Ethische Urteilsfindung im Kontext von KI-Systemen

Prof. Dr. Susanna Endres | Prof. Dr. Alexander Filipović

Veröffentlicht am 15.12.2023

„Die ethische Frage beim Umgang mit KI-Systemen lautet nicht mehr, ob man KI nutzen möchte, sondern, was das für das individuelle Leben und das gesellschaftliche Zusammenleben bedeutet.“ (Sūna 2023)

1 Einführung

Der nachfolgende Beitrag möchte aufzeigen, was die Feststellung aus dem angeführten Zitat bedeutet und welcher Kompetenzen es entsprechend bedarf, um ethisch-verantwortlich mit KI-Systemen umzugehen. Hierzu soll in einem ersten Schritt eine Annäherung an den Begriff „Künstliche Intelligenz“ erfolgen (Abschnitt 3.1). Hierauf aufbauend wird diskutiert, welche Bedeutung das Phänomen für unser alltägliches Leben hat (Abschnitt 3.2) und welche ethischen Anschlussfragen sich hieraus ableiten lassen (Abschnitt 3.3).

In einem weiteren Schritt wird diskutiert, wie sich die Wege hin zu einer ethischen Entscheidungsfindung gestalten (Abschnitt 4.1) und welche spezifischen Kompetenzen sich hieraus in Bezug auf das Phänomen „Künstliche Intelligenz“ ableiten lassen (Abschnitt 4.2). Zentral erscheinen an dieser Stelle auch Bezüge zum praktischen Handeln und Gestalten mit KI-Systemen. Um hierbei auch die Relevanz entsprechender Technologien für das individuelle Welt- und Selbstverständnis aufzuzeigen, werden Bezüge zur Medialität diskutiert und in der Ausformulierung von Kompetenzen Verweise zu Medienkompetenzmodellen und -konzepten herausgearbeitet (Kapitel 4.3). Verantwortung für einen aus ethischer Sicht guten Umgang mit KI-Systemen trägt in der Gesellschaft jedoch nicht nur das Individuum allein. Zum Abschluss des Beitrags werden deshalb weitere Verantwortungsdimensionen aufgezeigt und deren Zusammenwirken kritisch eingeordnet (Abschnitt 5).

2 Relevanz

2.1 Begriffliche Annäherung: KI – was ist das?

„Künstliche Intelligenz“ hat sich als Ausdruck für eine Vielzahl von computerbasierten Technologien durchgesetzt. Es gibt eine Reihe von formalen Definitionen, die hilfreich sind, weil sie dem „Mythos KI“ gegenüber auf Distanz bleiben. Bei Künstliche-Intelligenz (KI)-Systemen handelt sich nach einer dieser Definitionen um

„vom Menschen entwickelte Software- (und möglicherweise auch Hardware-) Systeme, die in Bezug auf ein komplexes Ziel auf physischer oder digitaler Ebene agieren, indem sie ihre Umgebung durch Datenerfassung wahrnehmen, die gesammelten strukturierten oder unstrukturierten Daten interpretieren, Schlussfolgerungen daraus ziehen oder die aus diesen Daten abgeleiteten Informationen verarbeiten und über die geeignete(n) Maßnahme(n) zur Erreichung des vorgegebenen Ziels entscheiden. KI-Systeme können entweder symbolische Regeln verwenden oder ein numerisches Modell erlernen, und sie können auch ihr Verhalten anpassen, indem sie analysieren, wie die Umgebung von ihren vorherigen Aktionen beeinflusst wird.“ (AI HLEG 2019, S. 47)

Diesen nüchternen Beschreibungen stehen unsere oft überraschenden Erfahrungen im Umgang mit KI-Systemen zur Seite. Wer beispielsweise mit generativer KI experimentiert und Text und fotorealistische Bilder entstehen lässt, die Ergebnisse variiert und verfeinert, der gerät ob deren Leistungsfähigkeit schon ins Staunen. Nicht zuletzt mit den generativen KI-Systemen dringt diese Art von Technologie in unser aller Leben ein.

2.2 Relevanz des Themas: Lebensweltbezüge

Doch auch wenn insbesondere Large Language Models wie ChatGPT oder Text-zu-Bild-Generatoren wie Stable Diffusion oder Dall-E die Schlagzeilen dominieren, repräsentieren sie doch nur einen kleinen Ausschnitt dessen, was KI in unserem Alltag bedeutet. Neben ChatGPT und Co. gibt es eine Reihe weiterer Beispiele für KI-Anwendungen im Nahbereich, die von den meisten Menschen regelmäßig genutzt, aber oft gar nicht als solche wahrgenommen werden. Ob Dialogsysteme wie Alexa oder Siri, Assistenzsysteme in Autos, Flaschenrückgabeautomaten, Suchmaschinen, Chatbots bei der Krankenversicherung, Streaming-Dienste, digitale Fotografie und deren Nachbearbeitung: In vielen alltäglichen Anwendungen sind Technologien integriert, die der obigen Definition von „Künstlicher Intelligenz“ entsprechen. Nahezu alle Lebensbereiche sind von KI-Systemen durchdrungen. Sie prägen Wirtschaft und Arbeit ebenso wie Politik, Bildung und Wissenschaft. Ein Ende dieser Entwicklung ist nicht abzusehen (Krotz/Schelhowe 2020, S. 6).

Dies bleibt nicht ohne Auswirkung auf das menschliche (Zusammen-)Leben und provoziert damit eine Reihe an ethischen Anschlussfragen. Hierbei würde es zu kurz greifen, lediglich den technisch-instrumentellen Charakter von „Künstlicher Intelligenz“ zu untersuchen. Vielmehr nehmen entsprechende Systeme durch ihre Allgegenwärtigkeit und ihre Ausformung stets auch die Rolle einer Vermittlungsinstanz zwischen Mensch und Welt ein. KI-Technologien können damit in einen direkten Bezug zu unserem Verständnis dessen gesetzt werden, was wir als „Medium“ begreifen. Ein derartiger Begriffszugang verweist auf einen metaphorischen Kern, der Vermittlung als eine Form der Ermöglichung von Verhältnissen zwischen Subjekt und Welt sowie Subjekten untereinander (und Subjekten zu sich selbst) beschreibt. Dabei „vermitteln“ Medien und Technologien nicht einfach nur und bleiben in diesem Akt unsichtbar und unschuldig. Marshall McLuhan, der Medien und Techniken weithin gleichsetzt (vgl. Margreiter 2016, S. 121 f.), begreift mit seinem Slogan vom „Medium als Botschaft“ (McLuhan 1964/1994, S. 21) Techniken und Medien als aktive Akteure in allen Akten von „Vermittlung“ (vgl. Krämer 2018, S. 33).

Indem KI-Systeme somit über ihre bloße technisch-instrumentelle Funktionalität hinaus tief in Mensch-Welt-Verhältnisse eingreifen, diese strukturieren und formen und umgekehrt wiederum durch menschliches Handeln geformt werden, erscheint es notwendig, bei der Ergründung zentraler Kompetenzen für einen ethisch-verantwortlichen Umgang mit entsprechenden Technologien über bloß instrumentell verstandene Technik- oder KI-Kompetenzen hinauszugehen. Es gilt also, den medialen, sozusagen den Selbst- und Weltzugangs-Charakter von KI-Systemen zu würdigen.

Es liegt daher nahe, für die Frage nach den spezifischen Kompetenzen für eine ethische Urteilsbildung zu KI bei ebenjenen Modellen anzusetzen, die die ethische Urteilsbildung im Bereich der (digitalen) Medien berücksichtigen. Nicht nur weil KI-Technologien „Medien“ im Sinne von Vermittlungstechnologien darstellen, sondern weil Medienkompetenzmodelle und -konzepte gerade den Zusammenhang von Ethik-Kompetenzen und Medialität (und damit auch Technizität) ganz grundsätzlich thematisieren. Ein entsprechender Rückbezug auf Medienkompetenzmodelle und -konzepte erscheint also insbesondere auch deshalb sinnvoll, da KI-Systeme, ähnlich wie klassische Kommunikationsmedien, als Vermittlerrolle im Alltag oft unsichtbar bleiben.

Ein weiterer Aspekt tritt noch hinzu und unterstützt das „Nichtwahrnehmen“ bzw. das „Nichterkennen“ von KI-Technologien im Alltag: die Form, wie das Thema in der Medienberichterstattung behandelt wird. Nicht nur die Auseinandersetzung mit dem Phänomen „Künstliche Intelligenz“ selbst erscheint deshalb aus ethischer Sicht geboten, sondern auch eine Reflexion des öffentlichen Diskurses und der Art und Weise, wie über KI-Systeme gesprochen wird (vgl. Filipović/Lamers 2022). Bereits der Begriff „Künstliche Intelligenz“ selbst kann an dieser Stelle problematisiert werden: Er ist unscharf und – wie eingangs bereits angedeutet – häufig mythisch aufgeladen. Er erinnert an Science-Fiction und weckt damit unrealistische Erwartungen. Damit einher geht die Gefahr, dass zunächst verborgen bleibt, dass bereits einfache algorithmische Entscheidungssysteme massive Auswirkungen auf Gesellschaft und Individuum haben.

Trotz dieser Unschärfe und obwohl der KI-Begriff nicht unumstritten ist, ist er heute so weit verbreitet, dass es schwierig ist, ihn aus dem (auch wissenschaftlichen) Diskurs gänzlich auszuklammern. Zu berücksichtigen bleibt, dass bereits die Bezeichnung des Phänomens die Vorstellungen darüber prägt. Wenn daher im Rahmen dieser Expertise die ethische Dimension von KI-Systemen und die Bedeutung ethischer Entscheidungsfindung in diesem Kontext diskutiert werden, müssen auch die mediale Darstellung von „Künstlicher Intelligenz“ – und die für deren Einordnung nötigen Kompetenzen – in den Blick genommen werden.

2.3 Ethische Anschlussfragen: Diskursfelder und Relevanz für Individuum, Institutionen und Gesellschaft

Der Ruf nach einer Ethik der KI ist überall zu hören. Wie mit jeder neuen Technologie ergeben sich auch hier Handlungsprobleme. Wofür soll und darf man KI einsetzen? Können und wollen wir Entscheidungen an Maschinen auslagern? Wird der Mensch nicht an vielen Stellen ersetzbar? Ethik kann bei der Lösung von Handlungsproblemen mithelfen. Ethik fragt nach dem Guten und Richtigen, fragt nach dem gelingenden Leben von Individuen und erörtert Folgen im Hinblick auf Gerechtigkeit für die Gesellschaft und das Zusammenleben.

Ethik setzt auf vielen Ebenen an, die sie miteinander kombiniert: Sie versucht nahe an der Technik und Entwicklung Expertise beizusteuern, etwa welche moralischen Kriterien herangezogen werden sollten, die ein KI-System dann berücksichtigen soll. Ethik hat hier oft auch eine Detektivfunktion: Sie ist sensibel für moralische Probleme und kann etwa darauf hinweisen, dass in den Daten, mit denen KI-Systeme trainiert werden, zum Beispiel Frauen oder People of Color unterrepräsentiert sind.

Neben der technischen Ebene richtet die Ethik ihren Blick auf den Bereich der Gestaltung, also auf den Bereich der Politik und der Governance im weitesten Sinne. KI-Systeme entstehen in der Wissenschaft oder in der unternehmerischen Technikentwicklung. Beide Bereiche sind geprägt von rechtlichen Normen, die die Politik setzt. Ethik hilft zu überlegen, ob KI-Systeme neu und anders reguliert werden müssen und welche Kriterien hier Anwendung finden. Sie spricht damit Institutionen der Gesellschaft an, die Regelungs- oder Gestaltungskompetenz haben.

Schließlich geht es der Ethik darum, Menschen zu befähigen, über das Gute und Richtige im Bereich des KI-Einsatzes selbstständig und kompetent nachzudenken. Diese Perspektiven richten sich wieder wesentlich an Institutionen, etwa an Bildungsorganisationen wie Schulen, aber auch an Universitäten, Hochschulen, Erwachsenenbildung, Kinder- und Jugendeinrichtungen und die Bildungspolitik und nicht zuletzt an den Menschen selbst, dem die grundlegende Fähigkeit zur Selbstbildung zugesprochen wird. Die Grundfrage ist hier, wie Bildungsprozesse ermöglicht und so verbessert werden können, dass Kompetenzen für gutes und richtiges Handeln im Kontext von KI gebildet werden. Selbstbestimmung ist hier ein wichtiges Kriterium, aber ebenfalls soziale Gerechtigkeit oder die Ermöglichung verantwortlichen Verhaltens.

2.4 Anforderungen an KI-Kompetenz und ethische Urteilsbildung

In den bisherigen Ausführungen wurde deutlich, dass bereits der Begriff und die Definition dessen, was wir im öffentlichen Diskurs unter „Künstlicher Intelligenz“ verstehen, als Herausforderung anzusehen sind und dass abhängig von der Perspektive, die auf entsprechende Technologien geworfen wird, jeweils ein spezifischer Rückgriff auf ausgewählte Kompetenzkonzepte und ‑modelle ratsam sein kann. Wenn es daher in diesem Beitrag darum gehen soll zu hinterfragen, wie Menschen lernen können, ethisch-verantwortlich mit KI-Systemen umzugehen, was deren Einsatz jeweils für sie selbst, ihren Zugang zur Welt sowie ihren Umgang mit anderen bedeutet, reicht es nicht aus, eine auf technische Funktionsweisen reduzierte Perspektive einzunehmen. Ein wichtiger Bezugspunkt wird – in der Annäherung an das Themenfeld und die damit verbundenen Kompetenzverständnisse und -konzepte – deshalb die mediale Dimension sein. Diese ermöglicht es, vertieft die Bedeutung der durch das Phänomen „Künstliche Intelligenz“ geschaffenen Möglichkeitsräume, die eigenen Handlungsoptionen sowie die Wechselwirkung bezüglich der Selbst- und der Weltstrukturen zu hinterfragen. In einer solchen Perspektive wird somit die Rolle von KI-Systemen und ihr Beitrag zur Strukturierung und Gestaltung (digitaler) Lebensrealitäten hervorgehoben. Ein entsprechender Rückbezug soll es ermöglichen, insbesondere auch die Doppelrolle, welche die jeweiligen Technologien für individuelle und gesellschaftliche Wert- und Normvorstellungen spielen, zu hinterfragen.

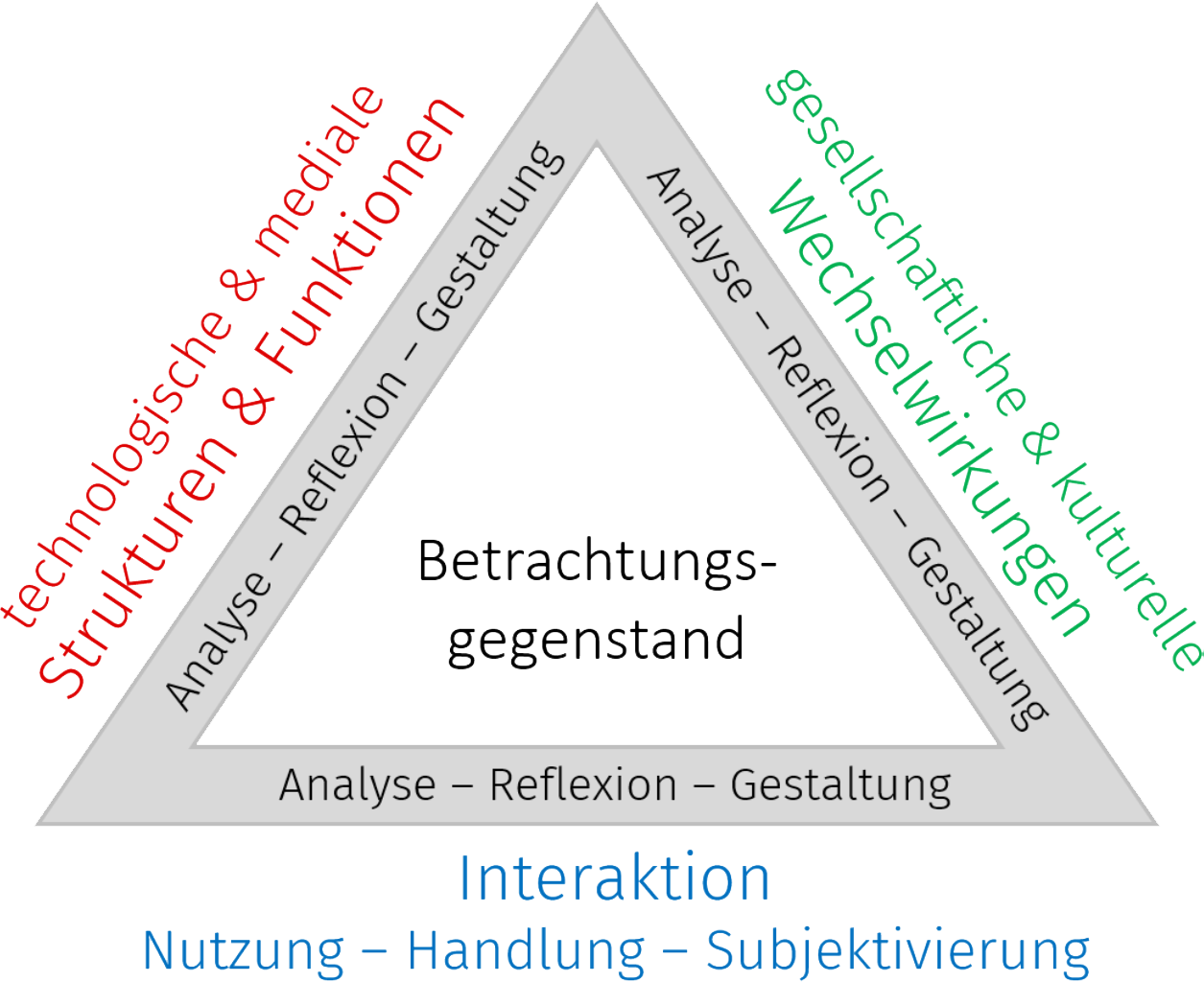

Ein Modell, das die Hintergründe im Kontext von Bildungsbezügen aufzeigt, ist das Frankfurt-Dreieck zur Bildung in der digital vernetzten Welt (Brinda et al. 2019). Das Konzept integriert Perspektiven aus der Informatik, Informatikdidaktik, Medienpädagogik und Medienwissenschaft. Die Grundidee des Dreiecks ist es, digitale Phänomene – wie eben KI-Systeme – sowohl im Hinblick auf ihre technologischen und medialen Strukturen und Funktionen als auch ihre gesellschaftlichen und kulturellen Wechselwirkungen zu durchdringen und die individuelle Interaktion hiermit in Bezug auf die Nutzung, Handlung und Subjektivierung zu hinterfragen. Dies geschieht jeweils in einer Abfolge aus „Analyse“, „Reflexion“ und „Gestaltung“. Obwohl das Modell die ethische Perspektive nur randständig erwähnt, wird durch einen derartigen methodischen Zugang eine strukturelle Verbindung zur ethischen Urteilsfindung deutlich, die sich in der Regel in den Dreischritt „Sehen – Urteilen – Handeln“ [1] . untergliedern lässt (s. u.).

Abbildung 1: Frankfurt-Dreieck zur Bildung in einer digital vernetzten Welt (Brinda et al. 2019, S. 3).

Das Frankfurt-Dreieck eröffnet durch seine Struktur nicht nur ein Verständnis für digitale Phänomene, sondern gibt auch erste Impulse für Bezugsebenen, auf die sich eine ethische Urteilsfindung beziehen kann.

3 Ethische Urteilsbildung im Kontext von KI-Systemen

3.1 Hintergründe: Wege zum ethischen Urteil

Ein ethisches Urteil ist eine begründete Überzeugung im Hinblick auf ein konkretes Handlungsproblem, das moralische Dimensionen aufweist. In dieser ersten Annäherung versteckt sich eine Vielzahl von heiklen Begriffen und Zusammenhängen. Was heißt „begründet“, was ist eine Überzeugung, was sind Handlungsprobleme und was unterscheidet ein moralisches Handlungsproblem von anderen, etwa sachlichen Problemen? Denn ob ich mir einen Kaffee oder alternativ einen Tee mache, mag ein Handlungsproblem sein, aber eine moralische Dimension weist diese Frage eher nicht auf. Ist die Verwendung einer generativen KI ein solches moralisches Handlungsproblem? Wie also funktioniert ethische Urteilsbildung?

Zunächst kann man mit Aristoteles (Anselm 2018, S. 40) sagen, dass eindeutige Problemlösungen in der Ethik zu erwarten ein Kategorienfehler ist. Aristoteles beharrt darauf, dass in der Ethik ein geringerer Grad an Bestimmtheit möglich ist als beispielsweise in der Mathematik. Ethisches Argumentieren darf zwar natürlich nicht gegen gewisse logische Regeln verstoßen. Aber es stellt gegenüber klassischen Begründungsverfahren „eine komplexe Kunst der Kombination“ von „Fakten, Normen und Intuitionen“ (ebd.) dar.

Nicht jedes moralische Handeln benötigt ein ethisches Urteil. Oft handeln wir moralisch, ohne überlegen zu müssen, was gut und richtig ist (Hilpert 2009, S. 30 f.), beispielsweise im alltäglichen Umgang mit unseren Freund*innen oder Beziehungspartner*innen. Erst wenn eine Handlungsunsicherheit aufkommt, suchen wir nach Gründen und Argumenten bzw. analysieren wir verstärkt eine Situation und kommen dann, nach diesem Prozess, zu einem (unter Umständen vorläufigen) Urteil.

Ethisch zu urteilen bedeutet nicht, dass jede*r sich je nach Stimmung und Kontext ein eigenes Urteil bilden kann, sondern wir sind gefordert, unser Handeln vor anderen zu rechtfertigen (vor allem wenn es, wie meist, andere Menschen betrifft), und werden daher Gründe für unser Handeln finden wollen, die von anderen verstanden und nachvollzogen werden können. Und, so Konrad Hilpert,

„zu diesen Gründen gehört nicht nur das Motiv, dessentwegen jemand im Innersten die betreffende Handlung verüben möchte, und nicht nur die festgelegten Normen, sondern auch die genaue Kenntnis des angefallenen Sachproblems sowie der Folgen, die daraus entstehen werden.“ (Hilpert 2009, S. 32)

Dieses Handeln auf der Basis eines ethischen Urteils nennt man auch „verantwortliches Handeln“.

Wenn wir uns diesen Prozess, bei dem am Ende ein ethisches Urteil und eine Handlung stehen, genauer anschauen (vgl. im Folgenden Hilpert 2009), finden wir meist die Struktur „Sehen – Urteilen – Handeln“ (s. o.). Die Situationsanalyse (Sehen) des ersten Schrittes lässt sich wie folgt unterteilen:

- Zunächst erfolgt eine sorgfältige Analyse des konkreten Problems. Ziele, Mittel und Sachstand werden hier geklärt.

- Daraufhin geht es um beteiligte Akteure und Kontexte. Interessen, Voraussetzungen, institutionelle Rahmen, rechtliche Bestimmungen usw. stehen hier im Mittelpunkt.

- Schließlich werden gegebene Handlungsalternativen und mögliche Problemlösungen evaluiert.

Wir erkennen hier eine deutliche Strukturgleichheit zu den allgemeinen Anforderungen an KI-Kompetenzen. Es ist wichtig zu sehen, dass sowohl eine sachliche als auch eine ethische Auseinandersetzung mit KI-Systemen immer mit einer vertieften Sachstandsanalyse beginnt. Die ethische Perspektive auf die Wahrnehmung (sozusagen der methodische Schritt des ethischen „Sehens“) fokussiert dabei verstärkt Akteure und Interessen sowie Institutionen und Recht.

Die Schritte der ethischen Prüfung (anhand von Bewertungsstandards) sind komplexer aufgebaut und unterscheiden sich deutlich von der bloßen Reflexion einer Wahrnehmung. Hilpert (2009, S. 34 f.) unterscheidet hier vier Schritte:

- die Verknüpfung mit ethischen Prinzipien,

- das Sichtbarmachen von werthaften Vorannahmen und gängigen Idealen über den Menschen und die kritische Diskussion darüber,

- die Feststellung des ethischen Kerns des Problems und die Abwägung bei konfligierenden Prinzipien, Werten und Idealen sowie

- die „Prüfung der Angemessenheit der Handlungsalternativen inkl. Blick auf die Folgen und Nebenfolgen“ (Hilpert 2009, S. 36).

Mit dieser ethischen Prüfung (dem methodischen Schritt des ethischen „Urteilens“) ist zwar ein ethisches Urteil gefunden, aber dieses Urteil bewährt sich nur im Kontext möglicher Praxis (also dem methodischen Schritt des ethischen „Handelns“):

„Seinen wirklichen Zielpunkt erreicht das ethische Urteilen nämlich erst im willentlichen Entschluss, das Erkannte auch zu tun. Denn ethische Urteile richten sich stets auf das, was werden soll. Sie enthalten also ein Gebot, das aber in seiner Inhaltlichkeit erst durch die Durchdringung der fachspezifischen Gegebenheiten, Bedingtheiten und relevanten Faktoren näher bestimmt und gewiss wird.“ (Hilpert 2009, S. 37)

3.2 Elemente der ethischen Urteilsfindung im Kontext von KI-Systemen

Mit dieser Strukturgleichheit der sachlich-kritischen Kompetenzen als Voraussetzungen für den Umgang mit KI (Abschnitt 3.4) und der Schritte der ethischen Urteilsbildung (Abschnitt 4.1) können wir nun konkreter die Elemente der ethischen Urteilsbildung im Kontext von KI-Systemen bestimmen.

3.2.1 Ethisches Wahrnehmen

Um ethisch urteilen zu können, bedarf es, wie in den bisherigen Ausführungen gezeigt werden konnte, zunächst der Wahrnehmung einer ethisch herausfordernden Situation. Mit Blick auf KI-Systeme zeigt sich hier eine besondere Herausforderung, da diese im Alltag häufig gar nicht bewusst als solche erkannt werden. Darauf deutet zumindest eine qualitative Studie unter Einbezug eines narrativen Ansatzes von Grimm, Müller und Trost (2021, S. 55) hin, in der entsprechende Entwicklungen von den befragten Mediennutzenden lediglich am Rande erwähnt werden.

Mit Blick auf die Bedeutung, die KI-Technologien für den erlebten Alltag der Menschen haben, erscheint dies durchaus als Herausforderung. An dieser Stelle kann technisches Hintergrundwissen über die Funktionsweisen von KI-Systemen dabei helfen, die Schnittstelle Mensch–KI-System wahrzunehmen und „zu verstehen, wie automatisierte Kommunikation funktioniert und wie Rollen in den digitalen Räumen definiert sind. Dies gilt umso mehr, als mit der Entwicklung von KI-Systemen immer weiter auch in unsere normativen gesellschaftlichen Rahmungen eingegriffen wird“ (Marci-Boehncke/Rath 2020, S. 31). Durch technisches Verständnis kann somit ein Bewusstsein für die „Mitarbeit“ der Menschen, z. B. durch das Zurverfügungstellen von Daten an KI-Systeme, reflektiert und die damit einhergehenden, sich verschiebenden Machtverhältnisse beispielsweise zwischen Unternehmen und Individuen bewertet werden [2] . (Distelmeyer 2021, S. 8).

Ein wichtiger und relevanter Schritt und Ausgangspunkt jeglicher Methode zur ethischen Entscheidungsfindung im Kontext von KI-Systemen muss daher sein, ein Bewusstsein dafür zu schaffen, was diese sind und welchen Einfluss sie auf das eigene Leben sowie die Gesellschaft und die ihr zugrunde liegenden Werte- und Normensysteme haben. So selbstverständlich sich der Ausgangspunkt „Wahrnehmung“ als Grundlage einer ethischen Urteilsfindung deshalb anhört, so voraussetzungsreich ist er.

3.2.2 Ethisches Urteilen

Zugleich dient der Prozess des ethischen Wahrnehmens als Basis für das Durchführen der sich hieran anschließenden ethischen Prüfung. Zentrale Grundlage der ethischen Prüfung ist dabei die Verknüpfung einer als problematisch wahrgenommenen Situation mit ethischen Prinzipien, ethischen Perspektiven und Werten (vgl. für diese Unterscheidung Filipović 2023).

Ethische Entscheidungsprozesse können dabei allein (in Rücksprache mit sich selbst) oder aber (vorzugsweise) im Austausch mit anderen vollzogen werden. Insbesondere wenn ethische Argumente in Gemeinschaft ausdiskutiert werden, werden auch für die ethische Urteilsbildung weitere Kompetenzdimensionen etwa aus dem kommunikativen Bereich relevant. (Kruip/Winkler 2010, S. 26)

Als Leitprinzipien kommen die obersten ethischen Prinzipien infrage, die sowohl praktisch-philosophisch als auch gesellschaftlich nicht hinterfragt, aber doch viel angeführt und diskutiert werden: Freiheit und Würde. Diese Prinzipien gelten unbedingt. Sie sind zwar abstrakt, stellen aber einen festen Grund dar, der die ethische Urteilsbildung anleiten kann. Diese Prinzipien setzen beim (sozialen) Individuum und seinen Rechten an. Im Kontext von KI-Systemen rückt damit in den Blick, ob und wie KI-Systeme individuelle Freiheiten vergrößern oder aber auch einschränken können. Das Prinzip der Würde verbietet, dass Menschen nur als Mittel gebraucht werden, Diskriminierungen erfahren oder dass ihre Rechte eingeschränkt werden. Alle diese Perspektiven sind beispielsweise für die Regulierung von KI-Systemen relevant, leiten aber auch den individuellen Umgang mit KI an.

Als Leitperspektiven kommen im Kontext von KI-Systemen Sicherheit, Nachhaltigkeit und Teilhabe ins Spiel. Leitperspektiven sind konkreter als Prinzipien, gelten aber über viele Handlungsunsicherheiten im Kontext von KI-Systemen hinweg. Sie setzen beim Verhältnis von Individuen zur technischen Umwelt und Gemeinschaft bzw. Gesellschaft an. Menschen sind fundamental verletzlich – in je unterschiedlicher Weise. Sicherheit betrifft den Umgang grundsätzlich verletzlicher Personen mit KI-Systemen. Sicherheit wird so von einer (weiterhin wichtigen) rein technischen Maßgabe zu einer Orientierung für die achtsame Entwicklung, die achtsame Vermarktung und die achtsame Verwendung von KI-Systemen. Sicherheit betrifft darüber hinaus auch Fragen der Ökologie und der Nachhaltigkeit. Teilhabe bringt darüber hinaus in den Blick, dass KI-Systeme als Mittel für gesellschaftliche Beteiligung verstanden werden müssen und in diesem Sinne auch jeder und jedem dafür zur Verfügung stehen sollten. Teilhabe ist eine Frage der Gerechtigkeit und umfasst gerade auch die Beteiligung an der politischen Gestaltung technischer Umwelten.

In Bezug auf KI-Systeme werden eine Reihe von Leitwerten relevant, die individuell und situationsbasiert zu diskutieren sind. Für unterschiedliche Bereiche und Situationen können hierbei jeweils verschiedene Werte relevant werden. Für Handlungen im Kontext von KI-Systemen kommen etwa Transparenz, Fairness, Respekt und informationelle Selbstbestimmung infrage. Im Gegensatz zu Leitprinzipien und Leitperspektiven sind Werte recht kontingent, kommen aber praktisch dauernd ins Spiel. Wichtig ist zu erinnern, dass Werte meist von individueller Identität abhängen, kulturell geformt sind und miteinander in Konflikt stehen können.

Ethische Prinzipien, Perspektiven und Werte können methodisch ganz unterschiedlich zueinander in Korrelation gesetzt werden. Ziel des ethischen Urteils muss es sein, geeignete Wege in Relation zu den identifizierten Handlungsproblemen zu finden und Konflikte zwischen unterschiedlich ins Spiel gebrachten Prinzipien, Perspektiven und Werten zu sehen, zu reflektieren und zu diskutieren.

3.2.3 Ethisches Handeln und Gestalten

Ziel ethischer Urteilsbildung ist es, Partizipation an der digitalen Lebenswelt zu ermöglichen und damit das selbstbestimmte, ethisch-verantwortliche Handeln zu unterstützen. Hierfür bedarf es jedoch über die Urteilsbildung hinaus auch einer grundlegenden Motivation, entsprechend der getroffenen ethischen Entscheidung zu handeln. Es reicht nicht aus zu wissen, was „das richtige Handeln“ ist – vielmehr muss dieses auch zu sich selbst in Bezug gesetzt, angenommen und durchgeführt werden (vgl. Abschnitt 4.1).

Wie das Handeln und die aktive Teilhabe in der Praxis dann jedoch umgesetzt werden und welche Kompetenzen im Rahmen der Umsetzung der getroffenen Entscheidung eventuell weiter relevant werden können, wird in der ethischen Bildung nur selten vertieft diskutiert (Maisenhölder 2019, S. 20). Anders in der Medienpädagogik: Häufig legen Modelle zur Medienkompetenz ihren Schwerpunkt gerade auch auf konkrete (meist praktische) Fähigkeiten und Fertigkeiten im Umgang mit Medien. Dieser Aspekt erscheint auch für Überlegungen zu einem ethisch-verantwortlichen Umgang mit KI-Systemen relevant, weshalb im nachfolgenden Kapitel am Beispiel der Kompetenzdimensionen des Rahmenkonzepts des Projekts „Digitales Deutschland“ Anschlüsse für die ethische Urteilsfindung im Kontext von KI-Technologien diskutiert werden sollen.

3.2.4 Metakompetenzen: ethisches Urteilen als Integration von Wahrnehmen, Prüfen und Gestalten

Der hier skizzierte Dreischritt zur ethischen Urteilsfindung verweist auf zentrale Kompetenzbereiche, die in Bezug auf KI-Systeme relevant werden. Eine entsprechende Unterteilung sollte jedoch weder über die Komplexität hinwegtäuschen, die mit jedem der drei Schritte jeweils einhergeht, noch den Eindruck suggerieren, dass die drei Felder jeweils unabhängig für sich bestehen bleiben. Die Fähigkeiten, entsprechende Bezüge herzustellen und vor allem die drei Schritte zur ethischen Urteilsbildung kompetent miteinander in Verbindung zu bringen, sollen an dieser Stelle als „Metakompetenzen“ bezeichnet werden.

So kann insbesondere in ethisch relevanten Situationen bereits der Akt der Wahrnehmung selbst als Handlung angesehen werden, der die Entscheidung, sich einem bestimmten Thema zuzuwenden, vorausgegangen ist. Eine „ethische Wahrnehmungskompetenz“ (Feeser-Lichterfeld/Heyer 2010, S. 158), die auch das Erkennen der moralischen Relevanz einer bestimmten Situation inkludiert, setzt damit ein umfangreiches Wissen über gesellschaftliche Wertesysteme sowie deren kulturelle Abhängigkeiten voraus.

Um diese erkennen und einordnen zu können und somit in der individuellen Urteilsfindung zu einem Ergebnis zu kommen, kann an dieser Stelle der Austausch mit anderen, der innere Dialog mit sich selbst sowie eine Auseinandersetzung mit dem öffentlichen Diskurs etwa im Kontext der Medienberichterstattung hilfreich sein. Kompetenzen im Umgang mit diskursiven Architekturen (ebd.) werden an dieser Stelle relevant – und können doch ebenfalls selbst als Schritt der (ethischen) Handlung betrachtet werden, da sich mit jeder Teilhabe am Diskurs zugleich auch eine Veränderung und Gestaltung der (digitalen) Welt vollzieht.

Aus ethischer Sicht erscheint damit ein geweiteter Blick auf das konkrete Handeln wichtig. So wird doch erst in diesem ersichtlich, dass die einzelnen Teilbereiche des Dreischritts „Sehen – Urteilen – Handeln“ fließend ineinander übergehen. Aus dem individuellen Handeln erwächst schließlich beständig Erfahrung, die jeweils für das zukünftige Handeln leitend sein wird: „Moralische Grundsätze sind […] nur in der Lage, aus der Gewohnheit sittlichen Handelns heraus zu erwachsen“ (Gröschner 2015, S. 42).

3.3 Kompetenzen für ethische Urteilsbildung im Kontext von KI-Systemen: Dimensionierungen

Um auch die medialen Dimensionen des Phänomens „Künstliche Intelligenz“ zu berücksichtigen (vgl. Kapitel 3.4), wird im Folgenden auf bestehende Medienkompetenzmodelle und -konzepte Bezug genommen. Hierbei sollen jedoch die Spezifika, die mit dem Phänomen einhergehen, nicht ausgeblendet werden. Denn auch wenn festgestellt werden kann, dass KI-Systemen eine mediale Dimension zu eigen ist, so bedingen algorithmische Artikulationsformen doch auch neue digitale Strukturen und Handlungsräume: So wird etwa die ursprüngliche Trennung zwischen „Werkzeug, Werkprozess und Werk“ aufgelöst. Der Code selbst tritt im metaphorischen Sinne sowohl als Pinsel, als Künstler sowie als Gemälde auf, wodurch sich neue Zugänge und Möglichkeitsräume ergeben (Jörissen 2014, S. 507). KI-Systeme werden „grundlegend hinsichtlich ihrer Dynamisierung, Performativität und Intransparenz“ charakterisiert (Verständig/Ahlborn 2020, S. 89) – mit einer Reihe an damit einhergehenden ethischen Anschlussfragen, die es in Bezug auf Medienkompetenzmodelle und -konzepte zu diskutieren gilt.

In bestehenden Überlegungen zur Medienkompetenz klingen diese in erster Linie im Bereich der kritisch-reflexiven Urteilsfähigkeit an, die in fast jedem Medienkompetenzkonzept eine wichtige Rolle spielt (Sūna 2023). Worauf sich eben diese Teilkompetenz jedoch im Detail bezieht und wie die Kritik inhaltlich gefüllt werden soll, bleibt in der Medienpädagogik in der Regel unbestimmt – weshalb hier erneut der Rückbezug auf die Ethik notwendig wird (Maisenhölder 2019, S. 21). Im Folgenden wird, um entsprechende Zusammenhänge aufzuzeigen, Bezug auf das Kompetenzverständnis des Projekts „Digitales Deutschland“ genommen. Dieses bezieht eine Reihe unterschiedlichster medienbezogener Kompetenzdefinitionen und -modelle mit ein und extrahiert hieraus folgende zentrale Dimensionen (Digitales Deutschland 2021, S. 5):

Die instrumentell-qualifikatorische Dimension bezieht sich in erster Linie auf die Fähigkeit, digitale Medien und Systeme zu bedienen sowie deren Funktionsprinzipien zu durchdringen. Diese Dimension kann – insbesondere mit Blick auf die Notwendigkeit, ethische Herausforderungen von KI-Systemen überhaupt erst wahrzunehmen – als wichtiger Ausgangspunkt für deren ethische Reflexion angesehen werden. Aber auch im Hinblick auf die Handlungsdimension werden Fähigkeiten der instrumentell-qualifikatorischen Dimension relevant (Koska 2023, S. 105). Um sich kompetent am ethischen Diskurs über und zu KI-Systemen beteiligen zu können, ist es hilfreich, praktische Erfahrungen mit ihnen gemacht zu haben. Und nicht zuletzt: Ein ethisch-verantwortungsvoller Umgang mit entsprechenden Technologien (oder auch eine begründete Nichtnutzung) ist ebenfalls nur dann möglich, wenn sie auch eingesetzt werden können.

Die kognitive Dimension bezieht sich in erster Linie auf die kognitive Auseinandersetzung mit den Inhalten von digitalen Medien und Systemen. Neben einer ethisch reflektierten Einordnung (digitaler) Medienprodukte geht es hierbei auch darum, sich deren medialer Beschaffenheit bewusst zu sein: Auch hier zeichnet sich eine Reihe von Anschlusspunkten zu medienethischen Fragestellungen ab (Dietrich 2004, S. 86). Um ethisch verantwortungsvoll handeln zu können, ist es so unabdingbare Voraussetzung, einerseits zwischen leiblicher Realität und Virtualität differenzieren zu können und sich andererseits der engen Verquickung beider Lebenswelten – die zunehmend zu einer werden – bewusst zu sein. Beide Ebenen der kognitiven Dimension sind mit Blick auf KI-Systeme von großer Bedeutung: Zunehmend wird es schwierig zu erkennen, welche Bilder und Texte von Menschen erstellt und welche durch KI-Technologien generiert wurden (Paganini 2022, S. 166). Neben entsprechenden praktischen Recherchefähigkeiten bleibt es den Mediennutzenden an der Stelle auch zu diskutieren, mit welcher Motivation welche Inhalte eventuell verbreitet werden und wie hiermit umgegangen werden kann und sollte. KI-Systeme haben darüber hinaus jedoch auch Einfluss darauf, welche Inhalte wir im digitalen Alltag angezeigt bekommen und welche Informationen uns von wem, wann und wie erreichen. Es gilt, hierfür sensibel zu sein und die Auswirkungen, die dies für unseren gelebten Alltag hat, zu hinterfragen.

Ethisches Urteilen und Handeln erfolgt nicht nur auf der Basis einer rein logischen, kognitiven Argumentation. Ob ethische Entscheidungen auch umgesetzt werden, ist nicht zuletzt auch von der Identifikation mit dem ethischen Urteil und dessen individueller Annahme abhängig (Hastedt 2021, S. 98). An ebendieser Stelle wird die affektive Dimension des Rahmenkonzepts des Projekts „Digitales Deutschland“ relevant. Diese umfasst die Fähigkeit der Mediennutzenden, die eigene Stimmung zu regulieren, Emotionen zu verarbeiten und empathisch zu handeln. Betrachtet man Gefühle aus einer emotionsphilosophischen Perspektive, geht man davon aus, dass diese bis zu einem gewissen Grad kontrolliert werden können und mit bestimmten Handlungsdispositionen verbunden sind. Gefühle beeinflussen unsere Wahrnehmung und unsere Meinungsbildung (Landweer 2012, S. 21).

Empathie schafft eine Verbindung zwischen Emotion und Intellekt: Sie umfasst einerseits die Fähigkeit, sich intellektuell in die Situation und die Intentionen anderer hineinzudenken, und andererseits, deren Emotionen und Gedanken zu verstehen und selbst nachzuempfinden (Roew/Kriesel 2017, S. 109). Empathie ist deshalb für die individuelle ethische Entscheidungsfindung wichtig: Das Einfühlen in die Perspektive anderer ermöglicht es, dass wir uns unserer eigenen Überzeugungen bewusster werden. Der Vergleich der eigenen Werte mit denen von anderen kann dazu führen, dass die eigene Haltung gestärkt oder neu justiert wird (Pfeifer 2020, S. 49).

Kompetenzen im Bereich der affektiven Dimension sind damit für die ethische Urteilsbildung in Bezug auf KI-Systeme von großer Bedeutung. Affektive Kompetenzen werden auch in der Interaktion mit KI-Systemen, einschließlich virtueller Entitäten wie Chatbots, relevant. Medien verwenden zunehmend Mechanismen, um Emotionen in Anwendungen wie Spielen, Filmen und Therapie-Apps zu erzeugen (Zoglauer 2022). Aus einer bedürfnisethischen Perspektive ist die Fähigkeit, Freude aus Medien zu ziehen und Inspiration für das eigene Leben zu gewinnen, wichtig (Funiok 2000; Keupp 2017). Die Frage, inwieweit KI-generierte Medienprodukte dieser Aufgabe gerecht werden können, bleibt angesichts des aktuellen Standes der Technologie zu prüfen.

Um die durch KI-Systeme geprägte Welt partizipativ mitzugestalten, die eigene Stimme zu erheben und somit selbst einen Beitrag dazu zu leisten, dass diese lebenswert ist, reicht es nicht aus, sie „lediglich“ kognitiv zu durchdringen. Vielmehr wird an dieser Stelle die kreative Dimension des Rahmenkonzepts relevant. Sie umfasst die Fähigkeit, digitale Medien und Umwelten zu gestalten und auch neu zu entwickeln. Aus ethischer Sicht werden hier in erster Linie zwei Perspektiven relevant: Nimmt man einerseits die Bedeutung, die digitale Lebenswelten für uns Menschen haben, ernst, so lässt sich hieraus ableiten, dass die Option, diese aktiv mitzugestalten, aus der Perspektive der Teilhabegerechtigkeit allen gleichermaßen zustehen sollte. Von dieser Warte aus lassen sich entsprechende Fähigkeiten auch ethisch begründen und zugleich auch die Forderung an entsprechende Plattformbetreibende ableiten, den Nutzenden diese Gestaltungsoptionen auch einzuräumen. Andererseits geht mit den digitalen Gestaltungsmöglichkeiten auch eine große Verantwortung für die Medien- und KI-Systeme-Nutzenden einher. Sie haben nicht nur die Möglichkeit, die digitale Umwelt kreativ zu gestalten, sondern sind auch dafür verantwortlich, dass dies auf eine gerechte und menschenfreundliche Art und Weise geschieht. Eine ethisch verantwortungsvolle (Mit-)Gestaltung der digitalen Lebenswelt wird insbesondere unter Einbezug von KI-Systemen wichtig. Diese ermöglichen es, rasch und ohne großes Hintergrundwissen Medienprodukte zu erstellen. Welche Formen des (kreativen) Einsatzes von KI-Technologien in diesem Sinne aus ethisch-moralischer Sicht zu befürworten sind und welche nicht, ist hierbei jedoch nicht immer einfach zu beantworten.

Relevant wird an dieser Stelle somit auch die soziale Dimension des Rahmenkonzepts. Diese verweist in erster Linie auf die Fähigkeit, mit anderen Menschen zusammenzuarbeiten und zu kommunizieren. Ebendiese Fähigkeiten werden auch für die ethische Urteilsbildung wichtig. Diese verlangt nach einer angemessenen Balance zwischen Anpassung und Selbstbestimmung sowie nach einem sensiblen Abwägen zwischen eigenen und fremden Interessen und Bedürfnissen. Umgekehrt stellt jedoch die Fähigkeit zum ethischen Urteilen eine Grundvoraussetzung für eine kompetente Teilhabe am (digitalen) Diskurs dar. Teilhabe am Diskurs und ethische Urteilsfähigkeit befinden sich somit in einem permanenten Prozess der gegenseitigen Verwiesenheit aufeinander. „Kompetenzförderung ist entsprechend zu verstehen als die Ausdifferenzierung von Grundfähigkeiten innerhalb eines Rahmens individueller biografischer Erfahrungen“ (Runtenberg 2016, S. 61).

Für das Phänomen „KI-Systeme“ spielt die soziale Dimension des Rahmenkonzepts auf mehreren Ebenen eine wichtige Rolle. So wird im gesellschaftlichen Diskurs ausgehandelt, wie mit entsprechenden Technologien zukünftig umgegangen werden soll. Um an entsprechenden Aushandlungsprozessen teilhaben zu können, bedarf es sozialer Kompetenzen. Umgekehrt wird Kommunikation insbesondere auf Social-Media-Plattformen zunehmend auch durch KI-Technologien gesteuert. Was ich sehe, wird durch automatisierte Systeme bestimmt und die Informationen, die mich erreichen, sind eventuell ebenfalls KI-generiert. Dies, ebenso wie den eigenen Umgang hiermit, gilt es zu hinterfragen.

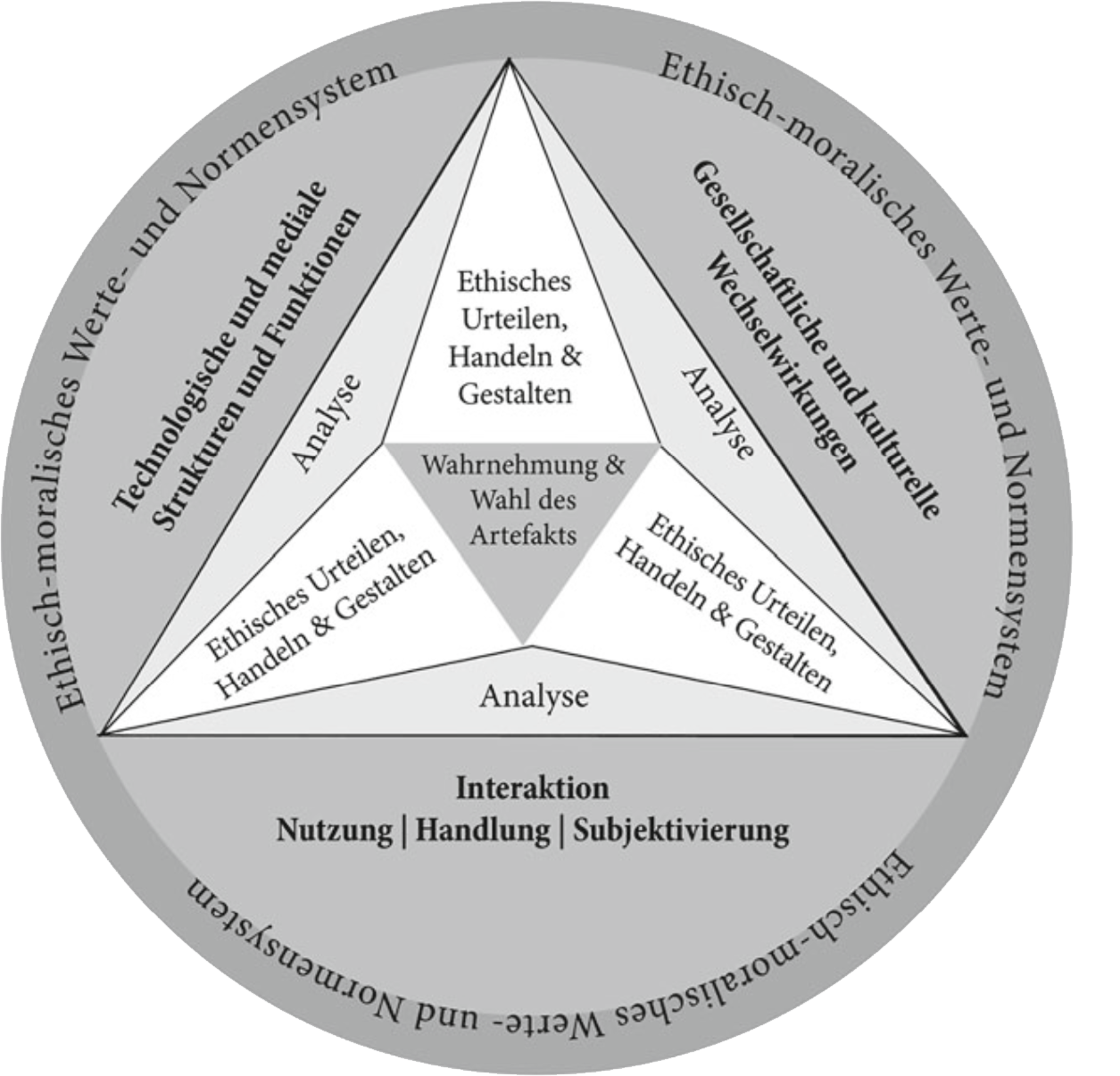

Damit wird nun auch die kritisch-reflexive Dimension des Konzepts angesprochen: Diese verweist auf den Bereich, der klassischerweise in Modellen und Entwürfen zur Medienkompetenz als „ethischer Bestandteil“ diskutiert wird. Hierbei geht es um die Reflexion und Bewertung von digitalen Medien und Systemen sowie deren Produktionsbedingungen. Für eine entsprechende ethische Urteilsbildung bedarf es jedoch wiederum, wie oben gezeigt wurde, einer Reihe von Kompetenzen, die auch in den anderen Dimensionen des Modells zum Tragen kommen. Ethische Urteilsbildung – insbesondere zu einem so komplexen Phänomen wie „KI-Systeme“ – ist somit als Querschnittsthema über alle Kompetenzbereiche und auch Bezugsfelder, wie sie beispielsweise im Frankfurt-Dreieck anklangen, zu betrachten. Die folgende Abbildung veranschaulicht entsprechende Zusammenhänge:

Abbildung 2: Medienethische Kompetenzen und ihre Bezugsfelder in Anlehnung an das Frankfurt-Dreieck (Endres 2023, S. 210).

4 Verantwortlichkeiten und Anschlussfelder

4.1 Das Individuum im Fokus

Wenn in den bisherigen Ausführungen der Schwerpunkt auf nötige Kompetenzen zur ethischen Urteilsfindung im Kontext von KI-Systemen gelegt wurde, so stand in erster Linie das Individuum im Fokus. KI-Systeme machen es einfach, selbst kreativ eigene Ideen für Medienprodukte umzusetzen bzw. umsetzen zu lassen. Damit geht jedoch auch eine gesteigerte individuelle Verantwortung einher, die es wahrzunehmen gilt. Verantwortung trägt man dabei nicht nur gegenüber anderen, sondern auch für sich selbst. Die Notwendigkeit einer Auseinandersetzung mit der Frage, für welchen Lebensentwurf man sich entscheidet, ist zutiefst mit unserem Menschsein verbunden (Fenner 2007, S. 1) und wird zugleich maßgeblich durch KI-Systeme geprägt.

Mit den erweiterten Gestaltungsmöglichkeiten nimmt auch die Verantwortung gegenüber anderen zu. Im Fokus stehen hierbei Kinder und Jugendliche, die einerseits vor als problematisch erachteten Medieninhalten zu schützen sind, deren Fähigkeiten im Umgang mit digitalen Medien und KI-Systemen umgekehrt jedoch auch gefördert werden sollten. Zugleich ist in diesem Kontext auch die individuelle Vorbildrolle zu reflektieren. Die Forderung nach Medienkompetenz über alle Zielgruppen hinweg, die mit digitalen Medien und damit auch mit KI-Systemen zu tun haben, wird deutlich. Medienbildung und das Streben nach digitaler Souveränität können daher aus ethischer Perspektive nicht nur im Kontext pädagogischer Verantwortung gesehen werden, sondern ganz allgemein als wichtige, lebenslange Selbstbildungsaufgabe (Funiok 2020, S. 144). Erschwert wird diese durch die Geschwindigkeit und die Dynamik, mit der sich KI-Technologien fortentwickeln:

„Dieser Prozess schafft jeweils veränderte Aneignungsbedingungen und Handlungsvorgaben bzw. -zwänge. Für die Menschen bedeutet dies, dass sie ihre Kompetenz jeweils weiterentwickeln müssen, da sie ansonsten gezwungen sind, sich den von außen gesetzten technischen und ökonomischen Zwängen anzupassen.“ (Schorb/Theunert 2023, S. 217)

Aus ethischer Sicht erscheint die Forderung an das Individuum, sich selbst beständig fortzubilden und neue Kompetenzen in Bezug auf die Fortentwicklung technischer Systeme zu erwerben, insbesondere auch deshalb als wichtig, da hiervon nicht zuletzt auch die soziale Teilhabe sowie die Option zur demokratischen Mitgestaltung der Gesellschaft abhängen (ebd.). Mit den zunehmenden Möglichkeiten von KI-Systemen in Bezug auf die Medienproduktion nimmt die Gefahr von Desinformation zu – mit nicht abzuschätzenden Folgen für die Glaubwürdigkeit von Medien allgemein. Ethische Urteilsbildung und Medienkompetenz in Bezug auf KI-Systeme können somit auch im Hinblick auf die individuelle öffentliche, staatsbürgerliche Mitverantwortung (ebd., S. 142) als relevant angesehen werden. Dies gilt sowohl im Hinblick auf journalistische Basiskompetenzen wie etwa Recherche und Fact-Checking als auch in Bezug auf die Rezeption, etwa im Sinne der Fähigkeit, die Glaubwürdigkeit einer Quelle zu überprüfen und Indizien für KI-generierte Medien zu (er-)kennen.

Aus medienethischer Sicht erscheint die Frage nach einem souveränen Subjekt unter digitalen Bedingungen zentral. So ist die Ermöglichung von Handlungsfreiheit eine Voraussetzung dafür, überhaupt erst Verantwortung für das eigene Tun übernehmen zu können (Fenner 2020, S. 204–206). Doch auch wenn die Idee einer souveränen Mediennutzer:innenschaft somit als ein erstrebenswertes Ziel der Medienethik betrachtet werden kann, bleibt doch zu konstatieren, dass vollständige Souveränität aufgrund externer Rahmenbedingungen, wie KI-Systemen, eine nie zu erreichende Utopie bleiben muss. Mit Blick auf digitale Gegebenheiten muss somit hinterfragt werden, inwieweit souveränes Handeln auf digitalen Plattformen

„angesichts der gewachsenen Konkurrenz technischer Systeme und Plattformen, die für uns entscheiden oder uns Empfehlungen geben, die qua strategischer Intransparenz Dystopien des Souveränitätsverlusts nähren; angesichts digitaler Medienökologien, die aktuelles Medienhandeln mit Mustern vergangenen Handelns in Verbindung setzen und denen Prognosen künftigen Handelns eingeschrieben sind; sowie durch mediale Komplexität, die verunsichert und einen Bedarf nach Kontingenzreduktion evoziert“ (Reißmann/Bettinger 2022, S. 4)

überhaupt möglich ist.

4.2 Der Diskurs über KI und seine Folgen

Eine wichtige Voraussetzung für das Ausbilden von ethischer Urteilsfähigkeit in Bezug auf KI-Systeme ist, dass diese in der digitalen Alltagswelt überhaupt als solche wahrgenommen werden – und wahrgenommen werden können. Neben der Ausgestaltung digitaler Technologien selbst spielt an dieser Stelle auch der Mediendiskurs über KI-Systeme eine wichtige Rolle. Dieser stellt „Künstliche Intelligenz“ häufig als etwas Verheißungsvolles und in die Zukunft Gewandtes dar. Nicht zuletzt in fiktionalen Unterhaltungsformaten spielen KI-Systeme eine wichtige Rolle. Während Utopien und Dystopien auf diese Art und Weise auf spielerischem Wege eine Reflexion von möglichen Handlungsempfehlungen, aber auch Warnungen in Bezug auf den Umgang mit den Potenzialen von Technologien ermöglichen (Bohrmann 2018, S. 37), verstellen sie auf der anderen Seite hierdurch jedoch auch den Blick auf das bereits bestehende Potenzial von KI-Systemen.

Eine ähnliche Gefahr zeigt sich auch in der Medienberichterstattung. Hier stehen häufig prominente und anschauliche Beispiele von KI-Technologien wie selbstfahrende Autos oder humanoide Roboter im Fokus. Dies verschleiert jedoch den Blick auf eher unscheinbare KI-Anwendungen, die bereits jetzt eingesetzt werden, aber oft nicht als solche wahrgenommen werden. Häufig dominiert immer noch die Vorstellung von „Künstlicher Intelligenz“ als einem „verkörperten Gegenüber“ (Mühlhoff 2023, S. 20).

Ein entsprechendes zeitliches und räumliches Framing von KI-Systemen als Zukunftstechnologie einerseits und als verkörpertes Gegenüber andererseits erscheint aus ethischer Sicht damit zu kurz zu greifen. So bleiben im öffentlichen Diskurs zentrale Herausforderungen von KI-Technologien im Hinblick auf strukturelle Faktoren digitaler Kommunikation zu wenig beachtet. Tatsächlich sind sie es jedoch, die weitreichende ethische Herausforderungen etwa im Hinblick auf die Beeinflussung der Wahrnehmung von Information, des individuellen Verhaltens, Denkens und Fühlens haben können (ebd., S. 21).

4.3 Unternehmen und die Gestaltung von KI

Neben dem Individuum, seinem Umgang mit KI-Systemen sowie seinen Vorstellungen hiervon ist für die Frage danach, wie die digitale Lebenswelt menschengerecht gestaltet werden kann, nicht zuletzt auch die Entwicklung von KI-Technologien ein zentraler Faktor. Damit treten Unternehmen als Verantwortungsträger ins Bild. Mit dem Schlagwort des Überwachungskapitalismus hat Shoshana Zuboff (2018) gezeigt, wie Unternehmen die kapitalistische Grundstruktur derart weiterentwickeln, dass sie mit unseren Daten Gewinne generieren. Sie zielen damit so geschickt auf unsere (psychischen) Bedürfnisstrukturen, dass wir dem aus eigener, individueller Kraft kaum etwas entgegensetzen können. Diese Problematik nimmt im Kontext von KI-Systemen zu. Wenn Gesetzgeber hier nicht oder nur vorsichtig tätig werden (wie etwa tendenziell in den USA), muss man auf die Verantwortung der Unternehmen bauen bzw. diese vehement einfordern und Ideen entwickeln, wie diese Verantwortung auch wahrgenommen wird.

Ein unethisches Verhalten von Unternehmen im Kontext von KI könnte sich negativ auf Ratings auswirken, sodass Unternehmen auch selbst ein Interesse haben, sich entsprechend zu verhalten. Dies könnte durch eine staatlich beaufsichtigte oder regulierte Selbstregulierung angezielt werden. Eine solche Unternehmensverantwortung wird unter dem Begriff der „Corporate Digital Responsibility“ diskutiert (vgl. Filipović 2024).

Aber auch auf der Ebene der Ausgestaltung von KI-Technologien selbst gibt es eine Reihe von Handlungsfeldern. Spiekermann (2021, S. 4) identifiziert diesbezüglich fünf Bereiche, die es vertieft zu berücksichtigen gilt:

- Zunächst gilt es zu diskutieren, wie das Forschungsfeld selbst ethische Theorien und Prinzipien berücksichtigen und auf dieser Basis z. B. Algorithmen sozialverantwortlich gestalten kann. Ein prominentes Beispiel, wie entsprechende Prozesse ablaufen können, ist das Projekt „Moral Machine“ des MIT, bei dem User*innen aus unterschiedlichsten Kulturkreisen im Rahmen einer spielerisch gestalteten Online-Umgebung mitentscheiden konnten, wie selbstfahrende Autos in einer Gefahrensituation reagieren sollten. (Awad et al. 2018)

- Schwerpunktmäßig in der Technikethik werden darüber hinaus auch Ansätze wie „Value Sensitive Design“ oder „Value Based Design“ entwickelt. Die Idee hierbei ist, Technologien von Anfang an wertebasiert zu konstruieren (Simon 2016; Jacobs/Jacobs 2022).

- Nicht außer Acht gelassen werden sollte an dieser Stelle jedoch auch, dass insbesondere mit Blick auf besonders schädliche oder riskante Technologieentwicklungen auch ein allgemeiner Diskurs darüber, ob diese überhaupt vorangetrieben werden sollten, durchaus gerechtfertigt sein kann.

- Der zuvor genannte Punkt verweist direkt auf die Frage, wie weit Forschungsfreiheit gehen kann und ob es nicht doch in bestimmten Bereichen Grenzen der Forschung gibt, die es zu wahren gilt.

- Abschließend steht für Spiekermann nicht nur die Frage im Fokus, welche Technologien entwickelt werden können und sollten, sondern auch, wer zu welchen Technologien wie Zugang hat (und [nicht] haben sollte).

Punkt 5 bezieht sich somit direkt auch wieder zurück auf das Individuum und seine Gestaltungsmöglichkeiten sowie auf die Frage danach, inwiefern der Mensch in Anbetracht so weitreichender Technologien wie KI-Systemen seiner individuellen ethischen Verantwortung gerecht werden kann:

„Der Erfolg der KI hängt […] nicht nur von den Konstruktionen der Wissenschaftler*innen und Ingenieur*innen ab, sondern auch von dem, was Menschen im Alltag mit Computern tun und wie die Maschinen mit der Umwelt interagieren.“ (Autexier/Schelhowe 2020, S. 18)

Zunehmend werden auch Ideen dazu diskutiert, inwieweit KI-Technologien dazu beitragen können, Kompetenzen zu fördern und Bildungsprozesse anzuregen. Entsprechende Überlegungen lassen sich auch auf ethische Lernprozesse übertragen. So können KI-Systeme in Bildungskontexten eine Reihe von Vorteilen mitbringen: Auf der Basis von Persönlichkeitsdaten können Lernprogramme individuell angepasst und didaktische Methoden situationsgerecht angewendet werden. Auf diese Weise können Lehrpersonen unterstützt werden oder gar vollständig digitale Lehr- und Lernsettings für das Ausbilden von medienethischen Kompetenzen optimiert werden. [3] Umgekehrt geht mit entsprechenden Settings eine Reihe von Herausforderungen – nicht zuletzt im Hinblick auf Privacy-Aspekte – einher, die es sorgsam abzuwägen gilt. (Schleiss et al. 2023, S. 17)

4.4 Rechtliche und gesellschaftliche Rahmenbedingungen – das Individuum im Kontext

Individuen begreifen ihr Tun eingebunden in gesellschaftliche und institutionelle Kontexte. Diese wirken normativ, sie bestimmen und definieren sogar erst individuelle Handlungsmöglichkeiten. Das betrifft auch den Bereich der KI-Systeme. Entsprechend ist für die Frage, welche Kompetenzen für eine ethische Urteilsbildung im Kontext von KI-Systemen notwendig sind, auch die soziale, gesellschaftliche, rechtliche, institutionelle und organisatorische Ebene zu berücksichtigen. Dies kann hier nur angedeutet werden.

Zunächst ist es für Prozesse der ethischen Urteilsbildung wie beschrieben notwendig, diese Ebene der Strukturen zu erkennen und in ihrer Relevanz zu verstehen. Dass und wie gesellschaftliche, rechtliche und institutionelle Strukturen Einfluss haben auf unsere individuelle Handlungsfähigkeit und -möglichkeit, muss erst einmal gesehen und gewusst werden. Dass nicht alles rechtlich möglich ist, was vielleicht praktisch möglich ist, muss gewusst werden. Ein Beispiel dafür ist etwa der Persönlichkeits- und Urheberrechtsschutz, wenn Bilder und Texte anderer in KI-Systemen umgestaltet werden.

Verantwortungsträger im Bereich der Gestaltung der angesprochenen Strukturen ist der Gesetzgeber und im erweiterten Sinne die Politik. Bestimmte KI-Systeme sollten vielleicht gar nicht vermarktet werden dürfen, weil Ansprüche an individuelles ethisches Verhalten eventuell zu viel verlangt sind. KI-Kompetenzen sind nur insofern zu fordern und auszubauen, wie auch der Gesetzgeber seiner Pflicht nachkommt, sichere Räume dafür erst zu schaffen. Mit der Forderung nach KI-Kompetenzen muss also auch immer die Forderung nach einer Regulierung von KI-Systemen auf der Höhe der Zeit einhergehen.

5 Ausblick

Im Beitrag wurde deutlich, dass die Frage der ethischen Urteilsbildung in Kontext von KI-Systemen die Lebensrealität der Menschen ganz praktisch betrifft: KI-Systeme sind nicht mehr nur fiktive Gedankenspiele von Romanautor*innen oder ein abstraktes Gedankenspiel für den akademischen Elfenbeinturm: Durch prominente Beispiele wie ChatGPT und Bildgeneratoren ist das Thema im öffentlichen Diskurs angekommen. Doch neben entsprechenden eindrucksvollen, spezifisch als „Künstliche Intelligenz“ beworbenen Anwendungen finden sich zahlreiche weitere KI-Technologien meist unbemerkt in unserem digitalen Alltag. Nicht zuletzt, wie wir mit ebendiesen umgehen, wie wir sie (nicht) einsetzen und uns auch auf politischer Ebene dafür engagieren und wie die Rahmenbedingungen für deren Nutzung aussehen, hat Auswirkungen darauf, wie sich unsere (digitale) Lebensrealität gestaltet. Deutlich wird: Es ist notwendig zu überlegen, was es bedeutet, ethisch-verantwortlich mit solchen Technologien umzugehen. Hierfür sind jedoch spezifische Kompetenzen notwendig, die aufgrund der besonderen Gestaltung von KI-Systemen einigen Anforderungen genügen müssen:

- Ethikkompetenzen sollten sich nicht nur auf die technische Dimension von KI-Systemen fokussieren, sondern auch die medialen Bezüge im Sinne dieser Technologien als Vermittler zwischen Selbst und Welt und umgekehrt berücksichtigen. Auf diese Weise kann die Bedeutung von KI-Systemen für die Fortentwicklung gesellschaftlicher und individueller Werte- und Normensysteme gewürdigt werden.

- Damit geht auch einher, dass das Phänomen multiperspektivisch zu betrachten ist. Hilfreich erscheint für eine solche Analyse und Beurteilung die Einteilung des Frankfurt-Dreiecks in die technisch-mediale und die gesellschaftlich-kulturelle Dimension sowie ein entsprechender Rückbezug auf das Individuum im Sinne einer Interaktionsperspektive.

- In diesem Sinne wäre es zu kurz gegriffen, die Anforderungen bezüglich der ethischen Urteilsbildung nur beim Individuum zu suchen: Externe Rahmenbedingungen, die von der Gesellschaft, dem öffentlichen Diskurs, den KI-Systeme bereitstellenden Unternehmen sowie den entsprechenden Technologien selbst geschaffen und gestaltet werden, nehmen an dieser Stelle eine bedeutende Rolle ein.

Ausgehend von oben skizzierten Anforderungen lassen sich zentrale Dimensionen einer Ethikkompetenz in Bezug auf KI-Systeme formulieren. Hierzu wurde im Rahmen des Beitrags Bezug auf die Kompetenzdimensionen des Projekts „Digitales Deutschland“ genommen:

- Ethische Urteilsbildung in Bezug auf KI-Systeme lässt sich in den Dreischritt „Sehen – Urteilen – Handeln“ einteilen. Dieser erfordert jeweils eine Reihe spezifischer Teilkompetenzen, die eine Brücke schlagen zwischen Ethik- und Medienkompetenzen.

- Zur Wahrnehmung gehört eine gewisse Sach- und Fachkompetenz, die sich sowohl auf Wissensinhalte in Bezug auf ethische Prinzipien sowie Werte- und Normensysteme stützt als auch auf das Wissen um technische Funktionsweisen von KI-Systemen und deren mediale Bezüge auf die individuellen Selbst- und Weltzugänge sowie die von ihnen bereitgestellten Partizipationsmöglichkeiten.

- Ethische Urteilskompetenzen bauen auf den skizzierten Wahrnehmungskompetenzen direkt auf und erweitern diese wie folgt:

- Im Vordergrund steht die Fähigkeit zur Verknüpfung der als ethisch relevant wahrgenommenen Situation mit ethischen Prinzipien, Perspektiven und Werten.

- Ethische Sach- und Fachkompetenzen werden damit auch im Schritt der ethischen Urteilsfindung relevant, wenn entsprechende Prinzipien, Perspektiven und Werte gekannt und miteinander in Verbindung gesetzt werden müssen.

- Im Abwägungsprozess werden darüber hinaus auch kommunikative Kompetenzen relevant, wenn die unterschiedlichen Entscheidungssituationen mit anderen oder sich selbst ausdiskutiert werden.

- Nicht zuletzt verweist der Bereich der ethischen Urteilskompetenzen auf basale Methodenkompetenzen, etwa wenn es darum geht, wie ethische Prinzipien, Perspektiven und Werte zueinander in Bezug gesetzt werden. Entsprechende Metakompetenzen verweisen auf den fließenden Übergang der Dimensionen des Dreischritts „Sehen – Urteilen – Handeln“.

- Der Bereich der ethischen Handlungskompetenz verweist auf praktische Fähigkeiten, wie sie u. a. in Medienkompetenzmodellen und -konzepten diskutiert werden. Es gilt dabei zu beachten, dass der Fokus auf die Medien nicht dazu führen sollte, dass ethisch relevante Spezifika von KI-Systemen unberücksichtigt bleiben.

- Relevant werden an dieser Stelle mit Blick auf das Rahmenkonzept des Projekts „Digitales Deutschland“ alle dort skizzierten Dimensionen in je unterschiedlicher Ausprägung.

- Die kritisch-reflexive Dimension erscheint aus ethischer Sicht dabei als übergreifende Ebene, die auch für alle anderen Teildimensionen eine bedeutsame Rolle spielt.

- Nicht zu kurz kommen sollte im Speziellen die affektive Dimension, da sie für den Zwischenschritt von der ethischen Urteilsfindung hin zur Handlung als zentral anzusehen ist.

Ob ethische Urteilskompetenz erworben und gefördert werden kann oder nicht, ist von einer Reihe von Einflussfaktoren abhängig:

- Zentral ist an dieser Stelle zunächst das Individuum selbst: Nur wenn dieses dazu bereit ist, sich auf ethisch relevante Situationen einzulassen, kann ethische Urteilsbildung gelingen und können somit auch entsprechende Fähigkeiten ausgebildet werden.

- Die individuellen Grunddispositionen sind jedoch nicht unabhängig von der gesellschaftlichen Gesamtlage zu sehen. Zu fragen gilt es hierbei, welche Rolle welchen ethischen Prinzipien, Perspektiven und Werten von wem zugesprochen wird. Wie wird es honoriert, ethisch verantwortlich zu handeln?

- Nicht zuletzt werden an dieser Stelle somit erneut Unterstützungsangebote zur Förderung und Schulung ethischer Kompetenzen in Bezug auf KI-Systeme relevant.

- Eine zentrale Rolle bei der individuellen und gesellschaftlichen Perspektive auf die Relevanz ethischer Grundsatzfragen in Bezug auf KI-Systeme nimmt an dieser Stelle somit erneut die mediale Aufarbeitung entsprechender Themen ein.

Die Förderung ethischer Urteilskompetenz ist also nicht zuletzt auch vom Individuum und seinen Grunddispositionen abhängig. Das bedeutet, dass bei der Frage nach Fördermöglichkeiten von Ethikkompetenz in Bezug auf KI-Systeme auch zwischen unterschiedlichen Zielgruppen unterschieden werden sollte. Zwar ist die Technologie selbst, wie im Rahmen des Beitrags an unterschiedlichen Stellen immer wieder durchklang, für alle Menschen relevant, allerdings gibt es doch größere Unterschiede in den individuellen Erfahrungsdimensionen und Lebensweltbezügen. Größere Differenzen lassen sich etwa auf das Alter der verschiedenen Zielgruppen oder auch auf deren fachliche Hintergründe und Tätigkeitsfelder zurückbeziehen. Ein besonderes Augenmerk verdienen zudem als vulnerabel wahrgenommene Zielgruppen, bei denen genau zu prüfen ist, inwieweit welche Kompetenzanforderungen vorausgesetzt werden können und welche Optionen des Schutzes gegenüber dem Einsatz von KI-Systemen eventuell zu fordern sind.

Wenn im Beitrag dargelegt wurde, was ethische Urteilsbildung in Kontext von KI-Systemen bedeutet, so schließt sich hier direkt die Frage an, wer für eine entsprechende Förderung überhaupt zuständig sein könnte:

- Die Förderung von Kompetenzen in Bezug auf die ethische Urteilsbildung kann als gesellschaftsübergreifende Aufgabe angesehen werden.

- Zunächst ist hierbei jedoch das Individuum selbst in den Blick zu nehmen: Aufgrund der Schnelllebigkeit und der technisch immer weiter voranschreitenden Entwicklung gilt es hier darauf zu verweisen, dass jede und jeder selbst dazu aufgerufen ist, sich ein Leben lang zu bilden und Kompetenzen in Bezug auf die eigene (digitale) Lebenswelt auszuformen, um somit ein gutes Leben in und mit digitalen Medien führen und gestalten zu können.

- Individuelle Selbstbildungskompetenzen werden insbesondere in einer demokratischen Gesellschaft, die von der Partizipation ihrer Bürger*innen lebt, wichtig: Nur wenn grundlegende Kompetenzen im Umgang mit KI-Systemen vorhanden sind, kann eine ethisch verantwortliche Teilhabe zur Mitgestaltung der gesellschaftlichen und kulturellen Rahmenbedingungen gelingen.

- Das Ausbilden individueller Fähigkeiten zur ethischen Urteilsbildung ist jedoch nur möglich, wenn die Gesellschaft entsprechende Möglichkeiten zur Förderung und Fortbildung für alle bereitstellt. Neben Kitas und Schulen sind darüber hinaus dezidiert auch andere Weiterbildungseinrichtungen sowohl von staatlicher als auch von Unternehmensseite mit gemeint.

- Auch niedrigschwellige Aufklärungsformate in Einrichtungen wie Museen, Bibliotheken oder in Form von Vorträgen können dabei helfen, ethische Urteilsbildung in Kontext von KI-Systemen zu unterstützen.

- Nicht zuletzt sollen an dieser Stelle auch weitere Optionen zur Förderung ethischer Urteilsbildung in der medialen Praxis angesprochen werden. So kann diese beispielsweise auch durch unterschiedliche Medien, deren Berichterstattung sowie in fiktionalen Formaten wie Romanen, Filmen oder Computerspielen angeregt und unterstützt werden.

- Auch KI-Systeme selbst können etwa in Form von Spielen oder im kreativen Einsatz dazu genutzt werden, ethische Urteilsbildung anzustoßen.

Auch KI-Systeme selbst können also die individuelle ethische Urteilsbildung unterstützen. Ob dies gelingt, ist nicht zuletzt abhängig von ihrem Design. Ausgehend von den skizzierten Kompetenzdimensionen sowie deren Voraussetzungen lassen sich bereits ein paar Hinweise dazu ableiten, wie KI-Anwendungen gestaltet werden könnten, um eine ethische Urteilsbildung zu erleichtern:

- So erscheint es zunächst zentral, dass KI-Systeme überhaupt erkannt werden. Ausgehend hiervon könnte es sinnig sein, transparent zu machen, an welcher Stelle KI-Systeme zum Einsatz kommen, und diese zu kennzeichnen.

- Hilfreich könnte darüber hinaus eine Aufklärung dazu sein, welche Konsequenzen mit der Nutzung der jeweiligen Systeme für das Individuum verbunden sind – also was etwa mit den eingegebenen Daten passiert, welche weiteren Daten eventuell erhoben werden usw.: Inwieweit ein solcher Verweis jedoch in jedem Fall praktikabel ist, bleibt zu diskutieren.

- Um individuelles ethisch verantwortliches Handeln und Gestalten mit KI-Systemen spezifisch im Medienbereich zu fördern, erscheint darüber hinaus auch eine kurze Aufklärung darüber, wie die Qualität der generierten Medienprodukte zu bewerten ist, sinnvoll: In Ansätzen wird dies beispielsweise bereits bei ChatGPT gemacht, indem darauf verwiesen wird, dass die Richtigkeit der generierten Antworten individuell jeweils nochmals zu prüfen ist. Ähnlich könnte es auch bei anderen KI-Systemen praktiziert werden, um die Gefahr von Desinformation im Netz durch irreführendes, durch KI-Systeme generiertes Text- und Bildmaterial zu verringern.

Anmerkungen und Quellen

- Der Dreischritt „Sehen – Urteilen – Handeln“ geht auf Cardijn, den Begründer der Jeunesse Ouvrière Chrètienne (JOC)/Christliche Arbeiterjugend (CAJ) zurück. Die Methode ist mittlerweile in der ethischen Bildung weit verbreitet. In der katholischen Soziallehre wurde der Dreischritt beispielsweise zum Leitfaden einer handlungsorientierten Sozialethik und auch ökumenisch ist er anschlussfähig. (Feiter 2018, S. 8)↩

- Beispiel: Navigationssysteme und GPS-Trackingsysteme sind hilfreich für den individuellen Gebrauch und laufen meist unbemerkt im Hintergrund mit. Wer hiervon final profitiert und wie die Daten und ihre Auswertung genutzt werden, bleibt dabei jedoch zunächst offen. So sind hierfür viele Anwendungsfälle von der individuellen Freizeitgestaltung, der Strafverfolgung durch die Polizei über PR- und Marketingunternehmen bis hin zu Versicherungen oder aber auch medizinische Einsatzzwecke denkbar.↩

- Eine umfangreiche Vorstellung von didaktischen Möglichkeiten zur Förderung medienethischer Kompetenzen und zur Anregung medienethischer Bildungsprozesse im Kontext von offenen Online-Umgebungen findet sich in Endres (2023b).↩

- AI HLEG (2019): Ethik-Leitlinien für eine vertrauenswürdige KI. Hochrangige Expertengruppe für künstliche Intelligenz eingesetzt von der Europäischen Kommission. Online verfügbar unter: https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=60425, Zugriff am 29.11.2023.↩

- Arant, David (2017): Die Potter-Box. Medienethik in der amerikanischen Journalistenausbildung. In: Wilke, Jürgen/Renner, Karl Nikolaus/Schultz, Tanjev (Hg.): Journalismus zwischen Autonomie und Nutzwert. UVK Verlagsgesellschaft mbH. S. 499–514.↩

- Autexier, Serge/Schelhowe, Heidi (2020): Interaktion und Künstliche Intelligenz. Herausforderungen für Gestaltung und Nutzung. In: merz. medien + erziehung 64, S. 12–19.↩

- Awad, Edmond et al. (2018): The Moral Machine experiment. In: Nature 563, S. 59–64.↩

- Bohrmann, Thomas (2018): Einführung in die ethische Filmanalyse. In: Bohrmann, Thomas/Reichelt, Matthias/Veith, Werner (Hg.): Angewandte Ethik und Film. Wiesbaden: Springer Fachmedien Wiesbaden. S. 37–57.↩

- Brinda, Torsten et al. (2019): Frankfurt-Dreieck zur Bildung in der digital vernetzten Welt. Ein interdisziplinäres Modell. Keine Bildung ohne Medien! (KBoM!). Online verfügbar unter: https://www.keine-bildung-ohne-medien.de/wp-content/uploads/2019/07/Frankfurt-Dreieck-zur-Bildung-in-der-digitalen-Welt.pdf, Zugriff am 29.11.2023.↩

- Christians, Clifford G. et al. (2020): Media ethics: cases and moral reasoning. 11. Aufl. London/New York: Routledge, Taylor & Francis Group.↩

- Debatin, Bernhard (2016): Verantwortung. Grundbegriffe der Kommunikations- und Medienethik (Teil 3). In: Communicatio Socialis 49, S. 68–73.↩

- Dietrich, Julia (2004): Grundzüge ethischer Urteilsbildung. Ein Beitrag zur Bestimmung ethisch-philosophischer Basiskompetenzen und zur Methodenfrage der Ethik. In: Rohbeck, Johannes/Philipsen, Peter-Ulrich (Hg.): Ethisch-philosophische Basiskompetenz. Dresden: Thelem. S. 65–96.↩

- Digitales Deutschland (2021). Rahmenkonzept. https://digid.jff.de/rahmenkonzept, Zuletzt aufgerufen am 29.11.2023.↩

- Distelmeyer, Jan (2021): Kritik der Digitalität. Wiesbaden: Springer Fachmedien Wiesbaden.↩

- Endres, Susanna (2023a): Medienethische Kompetenzen für eine digitale Welt. Ein interdisziplinäres Prozessmodell. In: Communicatio Socialis 56, S. 174–185.↩

- Endres, Susanna (2023b): Medienethische Bildung im digitalen Zeitalter: Überlegungen und Impulse zur Förderung medienethischer Kompetenzen im Rahmen offener Online-Kurse. Wiesbaden: Springer Fachmedien Wiesbaden.↩

- Feiter, Reinhard (2018): Pastoral und Methode. Zur Bedeutung Joseph Cardijns für die Pastoraltheologie. In: Krockauer, Rainer/Weber, Karl (Hg.): Mehrwert Mensch: zur Aktualität von Joseph Kardinal Cardijn. Berlin: LIT Verlag. S. 7–26.↩

- Fenner, Dagmar (2007): Das gute Leben. Berlin: de Gruyter.↩

- Fenner, Dagmar (2020): Ethik. Wie soll ich handeln? Tübingen; Francke.↩

- Filipović, Alexander/Lamers, Julian (2022): Die ethische Relevanz von KI-Diskursen. In: van Oorschot, Frederike/Fucker, Selina (Hg.): Framing KI: Narrative, Metaphern und Frames in Debatten über Künstliche Intelligenz. Heidelberg: heiBOOKS (FEST Forschung, 2), S. 137–154. https://doi.org/10.11588/heibooks.1106.c15197.↩

- Filipović, Alexander (2024): Corporate Digital Responsibility. In: Maximilian Kiener (Hg.): The Routledge Handbook of Responsibility. New York/London: Routledge, S. 419–430. https://doi.org/10.4324/9781003282242-45.↩

- Funiok, Rüdiger (2000): Legitime Bedürfnisbefriedigung in einer gemeinwohlorientierten Rahmenordnung. In: Schicha, Christian/Brosda, Carsten (Hg.): Medienethik zwischen Theorie und Praxis: Normen für die Kommunikationsgesellschaft. Münster: Lit. S. 53–61.↩

- Funiok, Rüdiger (2005): Medienethik. In: Hüther, Jürgen/Schorb, Bernd (Hg.): Grundbegriffe der Medienpädagogik. München: kopaed.↩

- Funiok, Rüdiger (2016): Werte (Teil 5). In: Communicatio Socialis 49, S. 322–326.↩

- Funiok, Rüdiger (2020): Verantwortliche Mediennutzung. Wünschenswerte Selbstverpflichtungen von Rezipient_innen und Nutzer_innen. In: Communicatio Socialis 53, S. 136–147.↩

- Grimm, Petra/Keber, Tobias O./Zöllner, Oliver (Hg.) (2020): Digitale Ethik: Leben in vernetzten Welten. Ditzingen: Reclam.↩

- Grimm, Petra/Müller, Michael/Trost, Kai Erik (2021): Werte, Ängste, Hoffnungen: das Erleben der Digitalisierung in der erzählten Alltagswelt. Baden-Baden: Academia.↩

- Gröschner, Alexander (2015): Pragmatische Medienkompetenz und Medienethik: pädagogische Anknüpfungen an John Dewey im digitalen Zeitalter. Jena: FORMAT Druckerei & Verlagsgesellschaft mbH, Garamond Verlag.↩

- Hastedt, Heiner (2021): Emotionen. In: Zeitschrift für Didaktik der Philosophie und Ethik 43, S. 98.↩

- Jacobs, Mattis/Jacobs, Stephan (2022): Value Sensitive Design in der digitalen Transformation. In: HMD Praxis der Wirtschaftsinformatik 59, S. 512–524.↩

- Jörissen, Benjamin (2011): „Medienbildung“ – Begriffsverständnisse und -reichweiten. In: Moser, Heinz/Grell, Petra/Niesyto, Horst (Hg.): Medienbildung und Medienkompetenz: Beiträge zu Schlüsselbegriffen der Medienpädagogik. München: kopaed. S. 211–235.↩

- Jörissen, Benjamin (2014): Digitale Medialität. In: Wulf, Christoph/Zirfas, Jörg (Hg.): Handbuch Pädagogische Anthropologie. Wiesbaden: Springer Fachmedien Wiesbaden. S. 503–513.↩

- Keupp, Heiner (2017): Identität. In: Schorb, Bernd/Hartung-Griemberg, Anja/Dallmann, Christine (Hg.): Grundbegriffe Medienpädagogik. 6., neu verfasste Auflage. München: kopaed. S. 153–159.↩

- Koska, Christopher (2023): Ethik der Algorithmen: Auf der Suche nach Zahlen und Werten. Berlin/Heidelberg: Springer Berlin Heidelberg.↩

- Krotz, Friedrich/Schelhowe, Heidi (2020): Ethik und KI. Editorial. In: merz. medien + erziehung 64, S. 6–11.↩

- Kruip, Gerhard/Winkler, Katja (2010): Moraltheoretische, entwicklungspsychologische und andragogisch-konzeptionelle Grundlagen ethischen Lernens. In: Gisbertz, Helga/Kruip, Gerhard/Tolksdorf, Markus (Hg.): Ethisches Lernen in der allgemeinen Erwachsenenbildung. Bielefeld: W. Bertelsmann Verlag. S. 5–55.↩

- Landweer, Hilge (2012): Freiheit, Widerfahrnis und Unverfügbarkeit. Der Wille zum Entgrenzen des Verfügbaren. In: Paragrana 21, S. 179–198.↩

- Maisenhölder, Patrick (2019): Die notwendige Verknüpfung von Medienpädagogik und Medienethik. In: Höfer-Lück, Hanna/Delere, Malte/Vogel, Tatjana (Hg.): Medien: Wissen – Können – Wollen. Festschrift zu Ehren Professor Dr. Dr. Matthias Rath. Dortmund: Forschungsstelle Jugend – Medien – Bildung. S. 21–23.↩

- Marci-Boehncke, Gudrun/Rath, Matthias (2020): Ein Blick auf die „Hinterbühne“. In: merz. medien + erziehung 64, S. 30–35.↩

- Margreiter, Reinhard (2016): Medienphilosophie. Eine Einführung. 2. erw. und verb. Aufl. Würzburg: Königshausen & Neumann.↩

- Mielke, Roger (2018): Resonanzraum der Demokratie – Evangelische Kirche, Werke und Verbände in Zeiten der Polarisierung. In: Forum Erwachsenenbildung 51, S. 18–22.↩

- Mühlhoff, Rainer (2023): Die Macht der Daten: warum künstliche Intelligenz eine Frage der Ethik ist. 1. Auflage. Göttingen: Universitätsverlag Osnabrück, VetR unipress.↩

- Paganini, Claudia (2022): Wie viel Wahrheit braucht die Welt? Ein (medien)ethisches Fazit. In: Eleftheriadi-Zacharaki, Sofia et al. (Hg.): Vom Umgang mit Fake News, Lüge und Verschwörung. Interdisziplinäre Perspektiven. Baden-Baden: Nomos Verlagsgesellschaft mbH & Co. KG. S. 159–174.↩

- Pfeifer, Volker (2020): Didaktik des Ethikunterrichts. Bausteine einer integrativen Wertevermittlung. Stuttgart: Kohlhammer.↩

- Reißmann, Wolfgang/Bettinger, Patrick (2022): Digitale Souveränität und relationale Subjektivität. Neue Leitbilder für die Medienpädagogik? In: merz medien + erziehung 66, S. 3–12.↩

- Roew, Rolf/Kriesel, Peter (2017): Einführung in die Fachdidaktik des Ethikunterrichts. Bad Heilbrunn: Verlag Julius Klinkhardt.↩

- Runtenberg, Christa (2016): Philosophiedidaktik: Lehren und Lernen. Paderborn: Wilhelm Fink.↩

- Schleiss, Johannes et al. (2023): Künstliche Intelligenz in der Bildung. Drei Zukunftsszenarien und fünf Handlungsfelder. Berlin: KI-Campus. https://doi.org/10.5281/zenodo.770262↩

- Simon, Judith (2016): Values in Design. In: Heesen, Jessica (Hg.): Handbuch Medien- und Informationsethik. Stuttgart: J. B. Metzler Verlag. S. 357–364.↩

- Spiekermann, Sarah (2021): Digitale Ethik und die Künstliche Intelligenz. In: Mainzer, Klaus (Hg.): Philosophisches Handbuch Künstliche Intelligenz. Wiesbaden: Springer Fachmedien Wiesbaden. S. 1–24.↩

- Spielkamp, Matthias (Hg.) (2019): Automating society. Taking stock of automated decision-making in the EU. AW AlgorithmWatch gGmbH. Online verfügbar unter: https://algorithmwatch.org/en/wp-content/uploads/2019/02/Automating_Society_Report_2019.pdf, Zugriff am 29.11.2023.↩

- Sūna, Laura (2023): Fokus-Auswertung zu Ethik und Medienkompetenz. In: Digitales Deutschland. Online verfügbar unter: https://digid.jff.de/fokus-auswertung-zu-ethik-und-medienkompetenz/, Zugriff am 29.11.2023.↩

- Süss, Daniel/Lampert, Claudia/Trültzsch-Wijnen, Christine W. (2018): Medienpädagogik. Wiesbaden: Springer Fachmedien Wiesbaden.↩

- Thies, Christian (2016): Tugend. Grundbegriffe der Kommunikations- und Medienethik (Teil 6). In: Communicatio Socialis 49, S. 417–421.↩

- Verständig, Dan/Ahlborn, Juliane (2020): Decoding Subjects? Über Subjektivierung und Kreativität im algorithmischen Zeitalter. In: Holze, Jens/Verständig, Dan/Biermann, Ralf (Hg.): Medienbildung zwischen Subjektivität und Kollektivität. Wiesbaden: Springer Fachmedien Wiesbaden. S. 77–94.↩

- Zoglauer, Thomas (2022): CyberDoc hat Sprechstunde. Intelligente Sprachdialogsysteme in der Gesundheitskommunikation. In: Sonar, Arne/Weber, Karsten (Hg.): Künstliche Intelligenz und Gesundheit. Ethische, philosophische und sozialwissenschaftliche Explorationen. Stuttgart: Franz Steiner Verlag. S. 227–243.↩

- Zuboff, Shoshana (2018): Das Zeitalter des Überwachungskapitalismus. Frankfurt/New York: Campus Verlag.↩

Zitationsvorschlag

Endres, S., Filipovic A. 2023: Ethische Urteilsfindung im Kontext von KI-Systemen. Im Rahmen des Projektes Digitales Deutschland. Online verfügbar: https://digid.jff.de/ki-expertisen/ethik-und-ki