Künstliche Intelligenz und Informatik

Prof. Dr. Ira Diethelm

Veröffentlicht am 15.06.2021

Begriff und konzeptionelle Vorstellung von Künstlicher Intelligenz

„Wo ist der Unterschied zwischen KI und Machine Learning? Ist es in Python geschrieben, ist es Machine Learning, ist es in PowerPoint geschrieben, ist es KI.“ (Informatiker-Witz)

Dieser Witz beschreibt zwei (von vielen) Seiten der KI und gleichzeitig zwei Perspektiven der Betrachtung: Die „wissende, gestaltende Sicht” (Python) und die „unwissende, (leicht)gläubige Sicht“ (Powerpoint). Im Modell der didaktischen Rekonstruktion (Kattmann et al., 1997, Diethelm et al., 2011) sind für die didaktische Strukturierung ebenfalls zwei Sichten zentral. Dort wird u.a. die Lernenden-Perspektive mit der fachlichen Klärung in ein gleichberechtigtes Verhältnis gesetzt. Dieser Ansatz soll auch hier helfen, das Thema zu strukturieren.

Es ist in der Informatik allgemein anerkannt, dass Künstliche Intelligenz (KI) als Begriff zu breit und eher als Sammelbegriff zu verstehen ist. So definiert Zweig (2019, S. 126): „Als künstliche Intelligenz (KI) bezeichnet man eine Software, mit deren Hilfe ein Computer eine kognitive Tätigkeit ausführt, die normalerweise Menschen erledigen.“ Diese erste, breite Definition von KI, so Zweig, bringt u.a. das Problem mit sich, dass es sich hier um ein sog. „moving target“ handelt. D.h. eine Tätigkeit wird als weniger intelligent wahrgenommen, sobald sie ein Computer ausführen kann, gerade weil sie ein Computer ausführen kann.

Alan Turing (1950) definierte ursprünglich, dass eine Maschine denken kann und damit als intelligent gilt, wenn sie im sogenannten Imitationsspiel von einem Menschen nicht zu unterscheiden ist. Im Jahr 2013 meldete die BBC, dass ein Computer Programm, das einen 13jährigen Jungen simulierte, den Turing-Test als erstes Programm der Welt bestand. Betrachtet man die Kommunikationsprotokolle, so drängt sich die Frage auf, ob der Test nicht nur deswegen bestanden wurde, weil man 13-jährigen Jungen aus der Ukraine viele unsinnige Antworten zutraut und sprachliche Defizite in Englisch verzeiht.

Sogenannte schwache KIs wie Chatbots und Spieleroboter, die von Kindern meist als freundlich, intelligent oder als Spiel- und Lernpartner wahrgenommen werden (Druga et al, 2017), uns unterhalten oder die Arbeit erleichtern, sind nur ein Aspekt der Lernendenperspektive auf KI. Wichtig ist auch die Extrapolation der zunehmenden Automatisierung des Alltags, Diskussionen über autonome Fahrzeuge und Waffensysteme und die damit verbundene Angst davor, was KI potenziell kann, wenn die sog. Singularität (= „Geburt“ einer starken KI) erreicht ist.

Welche Eigenschaften eine starke KI in den Vorstellungen der Bürger*innen hat, lässt sich u.a. von Hauptfiguren in Science-Fiction-Filmen wie Terminator, R2-D2, K.I.T.T., Commander Data und Agent Smith [1] ableiten. Als abstrakte, körperlose KI-Systeme wären Mother (bzw. MU-TH-UR, Alien), HAL (Odyssee im Weltraum), Skynet (Terminator) oder die Matrix zu ergänzen, die das Wohl von Menschen in der Regel anderen (Missions-)Zielen unterordnen.

Zu den Gefahren von KI äußerte sich 1951 Alan Turing in einem Vortrag: „ They would be able to converse with each other to sharpen their wits. At some stage therefore, we should have to expect the machines to take control.” Warnungen in Bezug auf eine starke, eher allmächtige KIs formulierten auch Stephen Hawking und Elon Musk. Derzeit geht man zwar nicht davon aus, dass die Entwicklung einer solchen KI kurz- oder mittelfristig bevorsteht (Deutscher Bundestag, 2020, S. 50). Dennoch schwingen in Diskussionen oft Ängste vor KI bzw. unerklärlicher, magischer Technik mit. Das dritte Clark‘sche Gesetz (1973) postuliert „Jede hinreichend fortschrittliche Technologie ist nicht von Magie zu unterscheiden“. Nicht selten werden IT-Systeme, die als autonom wahrgenommen werden, als ‚intelligent‘ oder ‚smart‘ bezeichnet, bspw. in der Werbung für Haushaltsgeräte. Somit ist für den Bildungsbereich noch eine dritte Definition relevant: Alle Technik, deren Verhalten sich Menschen nicht erklären können, wird als KI bezeichnet. Auch dies ist ein sog. „moving target“: In dem Moment, wo die Technik von Menschen hinterfragt und verstanden werden kann – erklärbar – wird, gilt diese Technik als weniger magisch und damit weniger intelligent und ggf. weniger angsteinflößend.

Insofern beschreibt der eingangs dargestellte Informatiker-Witz diese erklärbare Seite der KI, der die Intelligenz wieder verschwinden lässt und das betrachtete Phänomen erklärbar macht und als Machine Learning (als einen prominenten Begriff) definiert. Die Erklärbarkeit (explainability, explainable AI) nimmt daher als Begriff eine wesentliche Rolle in den heutigen wissenschaftlichen und politischen Diskursen zur KI ein. Machine Learning ist jedoch nur ein Teilbereich. Der Wissenschaftszweig der Informatik, der sich mit KI beschäftigt, teilt sich einerseits in körperlose KI-Systeme und sog. verkörperte KIs (vor allem als Robotik). Andererseits unterscheidet man Lernende KI-Systeme von regelbasierten KI-Systemen, deren „Verhalten vollständig durch algorithmische Regeln und maschinenlesbares Wissen von menschlichen Expertinnen oder Experten definiert ist“ (Deutscher Bundestag, 2020, S. 48).

Das Verhalten von Lernenden KI-Systemen (Machine Learning) ist stark von Trainingsdaten und Rechenleistung abhängig. Man unterscheidet überwachtes Lernen (supervised learning), unüberwachtes Lernen (unsupervised learning) und verstärkendes Lernen (reinforcement learning). Beim Deep Learning (tiefes Lernen) erfolgt die Strukturierung der Daten maschinell und gehört zum Lernprozess des Systems (Deutscher Bundestag 2020, S. 49). Diese Verfahren sind so komplex, dass ihre Entscheidungen durch Menschen schwer nachvollziehbar sind oder gar keine Erklärbarkeit besitzen. (Webb et al 2020).

Erklärbarkeit wiederum ist grob die Eigenschaft, zu verstehen und für Menschen verständlich zu beschreiben, was in so einer „Black Box“ geschieht und welche Ursachen zu diesem Verhalten geführt haben (Deutscher Bundestag 2020, S. 61). Die Enquete-KI unterscheidet und fordert neben Erklärbarkeit zusätzlich Transparenz und Nachvollziehbarkeit (ebd.). Transparenz meint dabei, in einer Art Beipackzettel den Einsatz von KI-Systemen überhaupt erkennbar zu machen und deren Eigenschaften zu beschreiben einschließlich der Herkunft, Art und Menge der zum Training genutzten Daten. Nachvollziehbarkeit ist dagegen die theoretische Möglichkeit, die Eigenschaften und das Verhalten unabhängig überprüfen zu können. (Gesellschaft für Informatik, 2020). Der Grad, in dem ein Mensch die Ursache einer KI-Entscheidung verstehen und ihr Verhalten abschätzen kann, ist in hohem Maße von der zugehörigen fachlichen Bildung des Menschen abhängig.

Webb et. al unterscheiden mit Bezug auf (ICO and Turing, 2019) insgesamt sechs Arten von Erklärbarkeit: Herleitung des Verhaltens (rationale explanation), Verantwortung (responsibility explanation), Datenherkunft (data explanation), Gerechtigkeit (fairness explanation), Sicherheit und Verlässlichkeit (safety and performance explanation) und Auswirkungen (impact explanation).

Daneben ist gilt die Haftung und Rechenschaftspflicht (accountability) als weiterer wichtiger Aspekt von KI-Systemen. Diese sollte immer bei (juristischen oder natürlichen) Personen liegen und nicht an die Technik delegiert werden, sobald Menschen von den automatisierten Entscheidungen (automated decision-making – ADM) betroffen sind, vgl. die „AI Ethics Guidelines Global Inventory“ [2] .

Digitalisierung und KI

Die Vielzahl der o.g. Begriffe, die in Zusammenhang mit KI diskutiert werden, zeigt bereits die Spannbreite der Diskurse und Forschungsbereiche von KI in der Informatik und angrenzenden Gebieten auf. In vielen dieser Bereiche begegnen sich gegenläufige Interessen. So entsteht zum Beispiel ein Konflikt zwischen der Forderung der Erklärbarkeit von KI-Systemen und dem Geschäftsgeheimnis von Firmen, die KI-Systeme nutzen. Die Unklarheiten wiederum bei der Frage nach der Rechenschaftspflicht werfen Forderungen auf wie etwa einen „Algorithmen-TÜV“.

Insbesondere ist der Bereich Vorurteilsfreiheit und Gerechtigkeit in Entscheidungssystemen ein großer ungelöster Bereich, da durch Trainingsdaten immer die in den Trainingsdaten enthaltenen Ungerechtigkeiten insbes. Diskriminierungen mitgelernt werden. Hier mit Regeln einzugreifen und das Verhalten „gerechter“ zu machen, ist nicht trivial, unter anderem deshalb, weil auch in regelbasierten und algorithmischen Systemen allgemein die Vorurteile der Programmierer*innen einfließen und bereits nicht-KI-Systeme vorurteilsbehaftet sind. Ein anderer Grund für die Schwierigkeiten mit einer Forderung nach Gerechtigkeit sind bekannte ethische Probleme wie etwa verschiedene Varianten des Trolley Problems, bei dem ein Bahnarbeiter entscheiden muss, ob er einen drohenden Zugunfall mit vielen Toten durch eine Weichenveränderung verhindert, die jedoch wiederum den Tod eines unbeteiligten Kollegen zur Folge hat, der auf dem Ausweichgleis steht.

Die Gesellschaft für Informatik hat 2019 zehn Zukunftsfragen [3] für KI formuliert, wovon die zehnte danach fragt, wie „Grundlagenwissen zu Künstlicher Intelligenz stärker in der Allgemein- und Weiterbildung veranker[t]“ werden kann. Der Diskurs um KI in der breiten Gesellschaft ist nur dann fundiert zu führen, wenn „möglichst viele Menschen über die entsprechenden informatischen Grundlagen verfügen und die dem Phänomenbereich maschinelles Lernen zugrundeliegenden Ideen und Konzepte verstanden haben sowie deren Möglichkeiten und Grenzen einschätzen können.“(Seegerer, Michaeli und Romeike, 2020)

Für den Bildungsauftrag von Schule allgemein und die Didaktik der Informatik im Speziellen entsteht daher im Lichte dieser Problemfelder das Desiderat Bildungsangebote zum Verständnis von Lernenden KI-Systemen und zur Reflektion über KI allgemein in Alltag, zu Hause, Schule und Beruf anzubieten oder obligatorisch einzurichten. Der Didaktik der Informatik kommt dabei in besonderem Maße die Rolle zu, das Verstehen und Gestalten der automatisierten Informationsverarbeitung zu fördern und so auch dazu beizutragen, dass vorhandene und künftige KI-Systeme, verstanden werden und beurteilt werden können. Sie trägt damit von fachdidaktischer Seite wesentlich zur Erklärbarkeit von KI-Systemen bei.

Die Lebensbereiche, die dazu aus didaktischen Gesichtspunkten herangezogen und diskutiert werden, sind dabei vielfältig aber immer auf den Alltag und die potenzielle Erlebbarkeit von durch KI verursachten Phänomenen ausgerichtet. Solche Phänomene können in jedweden Kontexten auftreten. Ob ein Phänomen dabei durch Algorithmen allgemein, durch regelbasierte oder lernende Systeme verursacht wird, ist dabei aus fachdidaktischer Sicht zweitrangig. Vorrangig ist für den Unterricht, die Kontexte, die aufgegriffen werden, gut auszuwählen. Als Kriterien für einen solchen guten Kontext, in dem u.a. auch KI als Unterrichtsgegenstand auftreten kann gelten beispielsweise die Mehrdimensionalität, Breite, fachliche Tiefe, Stabilität und Lebensnähe eines Sachverhalts (Diethelm, Koubek und Witten, 2011). Ein wichtiger Aspekt ist dabei, dass die verursachende Technik hinter alltäglichen Phänomenen aufgedeckt wird, um überhaupt einen Erklärungszusammenhang herstellen zu können. Sie können und sollten gerade in Bezug auf KI unterschieden werden nach folgenden drei Phänomenkategorien (angelehnt an Humbert u. Puhlmann, 2004):

Phänomene, die als direkt mit Informatik- bzw. KI-Systemen verbunden wahrgenommen werden (etwa die Interaktion mit Alexa, Siri und anderen Chatbots),

Phänomene, die als indirekt mit Informatik- bzw. KI-Systemen verbunden wahrgenommen werden (‚smarte‘ Stromtarife oder stark ausgefahrene Nebenstraßen)

und Phänomene, die keine konkreten Informatik- bzw. KI-Systemen erfordern, aber eine inhärent informatische Struktur oder einen großen Bezug zu lernenden Systemen besitzen (etwa die Laufzeit von Sortieralgorithmen oder Ablage von Information in Entscheidungsbäumen)

Die Fachdidaktik Informatik hat zusätzlich zum Verstehen und Erklären von digitalen Artefakten und Phänomenen u.a. das Ziel, die Schüler*innen zur Mitgestaltung von IT-Systemen zu befähigen. Die exemplarische Gestaltung (Programmierung) von Teilen solcher Systeme ist außerdem eine wichtige didaktische Methode zur Entmystifizierung von IT-Systemen und zur Erklärung ihrer Funktionsprinzipien. So haben sowohl ältere als auch neuere Unterrichtskonzepte zum Thema KI Anteile, in denen ein System angepasst wird, um die Funktionsweise von lernenden oder regelbasierten Systemen propädeutisch handelnd nachzuvollziehen [4] . (Chatbot Kontext, AI unplugged,).

Dabei steigert die Verbreitung von KI in besonderer Weise die Relevanz einer informatischen Bildung, die als grundlegenden Bildungsauftrag zur Mündigkeit der Bürger*innen ganz im Kant’schen Sinne beitragen möchte, so dass alle in der Lage sind, sich ihres Verstandes ohne die Leitung eines anderen (und auch ohne die Leitung einer Maschine) zu bedienen, die eigene Persönlichkeit frei entfalten zu können und gleichberechtigt an der digital vernetzten Gesellschaft teilhaben und diese mit gestalten zu können. Gleichzeitig sollen die Kinder und Jugendlichen dazu befähigt werden, Teil einer wehrhaften Gesellschaft zu werden, die sachkundig und kritisch über die Veränderungen im Zusammenhang mit Digitalisierung allgemein und KI im Speziellen urteilen kann.

Im Mittelpunkt des Unterrichts steht dabei nicht die binäre und vereinfachte Entscheidung, ob einzelne Personen an ihr teilhaben oder diese z.B. als Assistenzsysteme in ihrem eigenen Zuhause einsetzen soll. Ziel des Unterrichts ist es ihr vielfältiges Vorhandensein überhaupt zu erkennen („sehen“, Transparenz), Wirkzusammenhänge, Wirkprinzipien und Grenzen der Systeme zu kennen und zu verstehen sich damit in verschiedenen Kontexten das Verhalten begründet herzuleiten (rationale explanation, „verstehen“) und damit zu erklären, sowie die Systeme in Bezug auf Verantwortung (responsibility explanation), Datenherkunft (data explanation), Gerechtigkeit (fairness explanation), Sicherheit und Verlässlichkeit (safety and performance explanation) und Auswirkungen (impact explanation) beurteilen zu können. Wie in anderen Gebieten auch, ist zu diesem breiten Verständnis und für die entsprechende Urteilskompetenz (etwa analog zur Chemie und dem Umgang mit umweltgefährlichen Stoffen) ein exemplarisches Handeln und auch Mitgestalten von KI-Systemen notwendig.

Aus diesen Gründen ist eine Überarbeitung der Curricula verschiedener Fächer und insbesondere die bereits eingesetzte Stärkung des Schulfaches Informatik und der institutionalisierten Medienbildung zu erwarten, ähnlich wie in den 1980ern nach Tschernobyl der naturwissenschaftliche Unterricht über Radioaktivität und Umweltbildung gestärkt wurde.

Sollte diese breite Aufklärung der Bevölkerung über die Funktionsprinzipien und Grenzen von IT-Systemen allgemein und KI-Systemen im Speziellen ausbleiben, ist eine wachsende (akzeptierte) Unmündigkeit und Spaltung der Gesellschaft zu erwarten, wie sie etwa in der fiktionalen Literatur beschrieben werden, vgl. ‚Quality Land‘ von Marc Uwe Kling (2017) oder ‚Die Maschine steht still‘ von E.M. Forster (2016, Übers. des Originals von 1909).

Kompetenz und KI

Um den Einsatz von KI-Systemen hinterfragen und davon profitieren können, sind entsprechendes Wissen und Kompetenzen erforderlich (Deutscher Bundestag, 2020, S. 90). Peter Naur äußerte sich bereits 1954 über die Kompetenzen von Meschen in Bezug auf die Einschätzung von KI und nannte die Angst, dass der Mensch Sklave der Maschine würde, unbegründet (Borchers, 2016). Die Macht über das System läge vielmehr bei denen, die verstehen, wie es funktioniert (nach Humbert (2020) mit Verweis auf Naur (1968)).

Heute fallen viele Alltagssysteme unter die dritte (Science-Fiction-)Definition von KI. Viele IT-Systemen mit oder ohne maschinelles Lernen und werden als smart oder magisch wahrgenommen und verunsichern Menschen durch ihr unerwartet selbstständiges Verhalten. Deshalb ist die Diskussion um die nötigen Kompetenzen, die alle Bürger*innen in Zeiten von KI besitzen sollen, stark mit der Diskussion verknüpft, welche Kompetenzen alle Menschen in Bezug auf Informatik und IT-Systeme allgemein haben sollten. Dabei beschränkt sich die Diskussion in der Informatik nicht auf die erforderlichen Kompetenzen angesichts des Einsatzes von KI, sondern fordert auch die Befähigung aller zur Mitgestaltung von KI.

Die Enquete-Kommission „Internet und Gesellschaft“ forderte bereits 2011 neben den Kulturtechniken lesen, schreiben, rechnen auch technische Fähigkeiten (Umgang mit Hard- und Software, Grundverständnis vom Aufbau des Internets, Grundkenntnisse im Programmieren etc.) (Deutscher Bundestag, 2011, S. 32), die vor allem auf das Verstehen von Zusammenhängen abzielen. Medienkompetent ist demnach „beispielsweise nicht, wer gelernt hat, mit einem bestimmten Textverarbeitungsprogramm Serienbriefe zu erstellen. Medienkompetent ist, wer mit vertretbarem Zeitaufwand selbstständig in einem beliebigen Textverarbeitungsprogramm Serienbriefe erstellen kann, ohne es zuvor gelernt zu haben“ (ebd.). Analog dazu kann postuliert werden, dass jemand nicht etwa kompetent im Umgang mit und zur Beurteilung von KI ist, wer spezielle KI-Systeme kennt oder in einem bekannten Kontext nutzen kann, sondern wer in der Lage ist, ein neues System zu nutzen oder zu beurteilen, ohne dafür anwendungsspezifisch ausgebildet zu sein.

Eine Arbeitsgruppe der IFIP beschrieb die nötige Kompetenz aller Kinder in Bezug auf Computer wie folgt (Tinsley and Tagg, 1984): “[W]e should be concerned about three levels of use – the technical level (how and when to use them), the understanding level (why they bring about the results they do) and the reflective level (the personal and societal values involved in using them).” Die hier angesprochenen drei Sichtweisen findet man sowohl in der Dagstuhl-Erklärung zur Bildung in der digitalen vernetzten Welt als auch im darauf aufbauenden Frankfurt-Dreieck (2019).

Long, D., & Magerko, B. (2020) erarbeiteten in einer Metaanalyse eine Liste von 16 allgemeinen Kompetenzen für AI Literacy, die als notwendig erachtet werden, um KI zu verstehen. Angelehnt an diese Liste und an die von Puhlmann definierte „Informatische Literalität“ (Humbert, 2006, S. 51) sowie verschiedene Taxonomien (SOLO, Bloom) definiere und differenziere ich KI-Literalität wie folgt als die Fähigkeit einer Person,

die Rolle, die KI-Systeme und IT-Systeme insgesamt in der Welt aus technologischer, anwendungsbezogener und gesellschaftlich-kultureller Perspektive allgemein einnehmen und die Beteiligung von KI-Systemen an konkreten Situationen zu erkennen,

die groben Funktionsprinzipien und Grenzen von KI-Systemen sowie ihre Abhängigkeit von Daten zu kennen, verstehen und zu erklären, sowie

das mögliche Verhalten von KI-Systemen auf der Basis dieser Kenntnisse und dieses Verständnisses abzuschätzen und begründet herzuleiten,

KI-Systeme auf der Basis von Hintergrundwissen aus verschiedenen Bezugsdisziplinen (Informatik, Mathematik, Philosophie, …) aus technologischer, anwendungsbezogener und gesellschaftlich-kultureller Perspektive in Bezug auf Verantwortung, Sicherheit, Verlässlichkeit, Gerechtigkeit und Auswirkungen zu reflektieren und beurteilen,

KI- und andere IT-Systeme entsprechend den Anforderungen des gegenwärtigen und künftigen Lebens dieser Person als konstruktivem, engagiertem und reflektiertem Bürger zu nutzen und

gleichberechtigt und kreativ mitzugestalten.

Long, D., & Magerko, B. (2020) beziehen sich insbesondere auf Touretzky et al. (2019), die ebenso wie Webb et al. (2020) mit einer Reihe von sog. ‚Big Ideas in AI‘ beschreiben, was alle Kinder über KI, maschinelles Lernen und Robotik verstehen sollten. Sie lässt sich wie folgt übersetzen und zusammenfassen:

1. Wahrnehmung: Computer nehmen die Welt über Sensoren wahr und agieren in ihr auf der Basis von Algorithmen und durch vielfältige Gerätschaften. Zur Verarbeitung der Daten benötigen sie weitere umfangreiche Daten über die Einsatzdomäne.

2. Darstellung und Verhalten: Information wird in Computern in Form von digitalen Daten dargestellt. Agenten (Teilprogramme) nutzen und verwalten Daten-Modelle zur internen Darstellung der Welt und leiten daraus neue Daten und ihr Verhalten algorithmisch ab.

3. Lernen: Computer können aus Daten lernen. Sie finden Muster und berechnen dann eine wahrscheinlich zur Situation passende Antwort.

4. Interaktion: KI-Systeme auf angenehme Weise mit Menschen interagieren zu lassen, ist für die Entwickler*innen eine große Herausforderung. Die Agenten benötigen viele verschiedene Arten von Daten. Ihnen fehlen aber grundlegende Kommunikationsfähigkeiten und ein generelles Verständnis.

5. Einfluss: KI kann sich positiv und negativ auf die Gesellschaft auswirken. Daher müssen KI-Systeme, die Personen betreffen, transparent und fair sein und unter ethischen Aspekten konstruiert werden.

Zu jeder der fünf Ideen skizzieren Touretzky et al. (2019), auf welcher Alterststufen ab Kindergarten diese Ideen wie ausdifferenziert verstanden werden sollten und mit welchen Aktivitäten sich die zugehörigen Kompetenzen erwerben oder fördern lassen. Diese ‚5 Big Ideas in AI‘ bauen argumentativ auf den ‚10 Big Ideas of Computer Science‘ auf (Bell et al, 2018). Letztere enthalten m.E. weitere für KI-Systeme wichtige Punkte, die ich wie folgt ergänze:

6. Automatisierung: Algorithmen verarbeiten (lediglich) vorliegende Daten aufgrund festgelegter, genau formulierter Anweisungen, die nacheinander oder parallel abgearbeitet werden. Sämtliche mögliche Algorithmen bestehen dabei aus einer Kombination von immer gleichen, wenigen Grundbefehlen.

7. Programme: Algorithmen werden von Menschen in Form von Programmen so dargestellt, dass Computer sie ausführen können. Lernende Systeme können ihre eigenen Programme auf der Basis von Daten anpassen.

8. Grenzen: Es gibt algorithmische Probleme, die niemals durch Computer, auch nicht durch KI-Systeme, gelöst werden können (theoretische Unberechenbarkeit). Es gibt außerdem Probleme, deren Berechnung zwar theoretisch möglich wäre, jedoch praktisch nicht in angemessener Zeit endet.

9. Sicherheit: Vertraulichkeit, Verfügbarkeit und Integrität sind entscheidend für die zuverlässige Funktion aller Computer-Systeme. Das schwächste Glied in der Kette ist oft der Mensch, sowohl als Programmierer*in als auch als Nutzer*in.

10. Vernetzung: Computer benötigen zur Kommunikation miteinander feste Absprachen in Form von Protokollen und Schnittstellen.

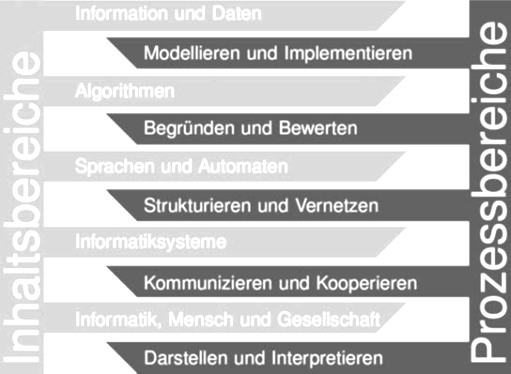

In beiden Ideenlisten und der damit geforderten Kompetenz werden viele Bereiche adressiert, die in den Empfehlungen der Gesellschaft für Informatik für verschiedene Schulstufen ausführlich ausdifferenziert wurden und in Abb. 1 dargestellt sind (Primarstufe 2019, Sekundarstufe I 2008).

Abbildung 1: Kompetenzmodell zur informatischen Bildung der Gesellschaft für Informatik

Sowohl Touretzky et al. (2019) als auch die Empfehlungen der GI schlagen einen spiralcurricularen Ansatz vor, bei dem schon früh ab der Primarstufe erste Erfahrungen, Erklärungsansätze und sowohl eigenes Handeln mit als auch (ggf. propädeutisches) Gestalten von IT- bzw. KI-Systemen der Kinder und Jugendlichen gefordert werden. Dadurch soll schon früh die Selbstwirksamkeitserwartung der Kinder gestärkt und die Komplexität der Systeme schrittweise erfahrbar gemacht werden, um eine auf Sachkompetenz aufgebaute Beurteilungskompetenz zu erzielen. Es werden stets Kompetenzen der Inhaltsbereiche mit Kompetenzen der Prozessbereiche verknüpft. Beispiel: „Die Kinder entwerfen einen Algorithmus zur Verschlüsselung von Daten“ (GI, 2019, S. 7). Mit zunehmender Altersstufe wandert der Fokus von Kompetenzen, die auf das Verständnis der Funktionsweise abzielen (z.B. das Nachempfinden durch Rollenspiele oder das Arbeiten mit Pappmodellen) zu Kompetenzen zur Gestaltung / Schaffung von lauffähigen IT-Systemen. Beide Bereiche sind und sollten auch in Bezug auf KI-Kompetenzen untrennbar miteinander verknüpft werden.

Die oben formulierten zehn Ideen sowie die Kompetenzempfehlungen der GI bis zum Ende der Sekundarstufe I sehe ich als notwendig an, um den Anforderungen von KI gerecht zu werden und alle Bürger*innen zu einer mündigen Teilhabe an und Mitgestaltung der zunehmend digital geprägten Gesellschaft zu befähigen.

Zusätzliche Kompetenzen sind in all den beruflichen und politischen Bereichen erforderlich, die KI-Systeme gestalten und über die Einführung solcher Systeme in Entscheidungsprozessen entscheiden. Darüber hinaus sind vertiefte Kompetenzen zur KI in ihrem speziellen Anwendungsfeld bei all denen erforderlich, die in ihrem KI-Systeme beruflich einsetzen und sich in ihren Handlungen ggf. von den Empfehlungen von KI-Systemen leiten lassen, beispielsweise Ärzte, Finanzdienstleister oder Lehrkräfte.

Diese Kompetenzen sind in besonderem Maße für alle Lehrkräfte wichtig, da diese einerseits die Aufgabe haben, in verschiedensten Fächern über den Einfluss und die Auswirkungen von KI auf die jeweilige Fachwissenschaft und den ihr eigenen Erkenntnismethoden einerseits und auf die Gesellschaft allgemein im Unterricht Bezug zu nehmen. Andererseits stehen alle Lehrkräfte vor der Aufgabe, den sinnvollen Einsatz von digitalen Medien allgemein und KI-basierten Unterstützungssystemen für das Lernen auf Seite der Schüler*innen und als Unterstützung in der pädagogischen Arbeit oder zur Bewertung von Leistungen der Schüler*innen zu beurteilen.

Gelingensbedingungen des Kompetenzerwerbs

Zentrale Gelingensbedingungen sind einerseits die Qualität des Kompetenzerwerbs und die Möglichkeiten des Kompetenzerwerbs. Dazu muss die Zielvorstellung reflektiert werden: Angesichts der hohen Dynamik der Domäne ist die Entwicklung von Kompetenzen, die anstreben, ein Individuum auf einen jetzt bekannten Stand zu bringen, der falsche Ansatz. Informatik ist und war immer sehr dynamisch. Das zeichnet sie aus und sie ist selbst der Grund für diese Dynamik. Der Zustand, mit dem Kinder und Jugendliche sowie alle Bürger*innen umgehen können müssen, ist der Zustand des stetigen Wandels. Deshalb ist es besonders wichtig, die langlebigen Prinzipien wie die o.g. zehn Ideen als Grundlage dieses Kompetenzerwerbs fest in der formalen Bildung zu etablieren und sie den gleichen Anforderungen zu unterziehen wie beispielsweise naturwissenschaftliche Fächer.

Der Wissenschaftsrat rät daher deutlich zu einer Stärkung des Schulfaches Informatik und der zugehörigen Lehrkräftebildung einerseits und zur Stärkung der Fachdidaktischen Forschung zur Didaktik der Informatik (Wissenschaftsrat, 2020). Informatik wird dort als Grunderfordernis für die digitale Mündigkeit angesehen.

Für den Aus- und Fortbildungsbereich ist es wichtig, dass ein Grundgerüst an nötigen Kompetenzen aller Menschen und insbesondere aller Menschen in pädagogischen Berufen haben sollten, die so präzise formuliert sind, dass daraus gut Ausbildungs- und Studiencurricula und Fortbildungsangebote sowie ergänzende Zertifikate für verschiedene Lehrberufe entwickeln zu können. Diese sollten angesichts der großen Lücke, die die allermeisten im Dienst befindlichen Personen voraussichtlich in diesem Bereich aufweisen, so gestaltet sein, dass sich ein Markt für Fort- und Weiterbildung entwickeln kann und gleichzeitig eine Qualitätssicherung ermöglicht wird. So ein KI-Kompetenzraster für alle und zusätzlich für Pädagog*innen könnte sich am GeRRI (Röhner et al., 2020) orientieren. Auch eine Orientierung an Online-Angeboten wie den „elementsofai.de“ ist zu prüfen.

Durch eine verpflichtende Etablierung der Kompetenzen zur KI (und Informatik allgemein) und einen alltagsnahen Unterricht in den Schulcurricula aller Schulstufen für alle Kinder und Jugendlichen würden nicht nur die Schüler*innen erreicht. Sondern die Schulkinder wirken auch als Multiplikator*innen in die Familien, da die Schüler*innen damit im heimischen Umfeld direkt als Expert*innen wahrgenommen werden und familiär eine gleichberechtigte Teilhabe ermöglichen.

Bezug zum Rahmenkonzept

Die hier von mir formulierten Kompetenzbereiche und -stufen korrespondieren teilweise mit den im Rahmenkonzept genannten Dimensionen. So wird in der instrumentell-qualifikatorischen Dimension zwar die Auseinandersetzung mit informatischen Modellierungen und Algorithmen angesprochen. In welcher Weise dies geschieht, ist aber m.E. zu wenig ausdifferenziert bzw. bleibt auf die „Bedienung“ von digitalen Medien und Systemen beschränkt. Das geforderte Verständnis ist wiederum in der kognitiven Dimension angesprochen, eine tiefere Ausdifferenzierung im Sinne der o.g. KI-Literalität und zehn Kernideen wäre zur Erfassung von KI durch diese Dimensionen jedoch anzuraten.

Die kreative Dimension geht darauf ein, dass Medien nicht nur rezeptiv genutzt, sondern auch selbst gestaltet werden können. Ebenso wird das Gestalten von Systemen angesprochen. Hier sollte das Produzieren und Gestalten von (passiven) digitalen Artefakte (Text, Ton, Film, usw.) und die Erschaffung und Mitgestaltung (aktiver/prozessualer) digitaler Artefakte (Makros, Apps, Roboter, Chat-Bots, Smart-Home-Automatisierung bis hin zu großen Infrastrukturen wie neuen sozialen Netzwerken) stärker unterschieden und getrennt von der Verwendung gegebener Technik unterschieden werden. Die Befähigung der Bürger*innen zu diesem Übergang ist ein wichtiger Emanzipationsschritt und für die Demokratisierung von Technik essenziell. Dieser Übergang wird im Konzept auf S. 6 unten bereits als neues Forschungsfeld ausgewiesen und sollte weiter in den Blick genommen werden. Es ist also mit Blick auf die anzustrebende Mündigkeit aller Bürger*innen zu empfehlen, dass nicht nur nach nötigen Kompetenzen zum Einsatz von (gegebenen) KIs gefragt wird, sondern die Möglichkeiten zur Teilhabe an ihrer Mitgestaltung durch die Fragerichtung explizit eingefordert und nicht ausgeschlossen wird.

Genau das Spannungsfeld, das sich auftut, wenn das Produkt menschlichen Schaffens nicht mehr nur passiv, unveränderlich existiert und unterschiedlich auf Individuen wirkt, sondern die zu Rede stehende Sache ein autonom handelndes Artefakt (einschließlich der dies ermöglichenden technischen Systeme) ist, ist die Schnittstelle zur Informatik.

Verweise

- https://gi.de/meldung/allensbach-umfrage-terminator-und-r2-d2-die-bekanntesten-kis-in-deutschland/↩

- https://inventory.algorithmwatch.org↩

- https://gi.de/meldung/ki-fachleute-benennen-10-zukunftsfragen-der-ki-entwicklung↩

- https://medienwissenschaft.uni-bayreuth.de/inik/entwuerfe/chatbots/, https://www.aiunplugged.org/, https://www.ddi.tf.fau.de/schule/unterrichtsmaterialien/ai-unplugged/, https://ai4k12.com/↩

Literatur

Bell,T., Tymann,P. & Yehudai, A. (2018). The Big Ideas in Computer Science for K-12 Curricula. Bulletin of the European Association for Theoretical Computer Science, 124

Borchers, D. (2016). Zum Tode von Peter Naur: Schlimmer als denkende Maschinen sind Menschen, die nicht nachdenken. Heise Online. https://www.heise.de/newsticker/meldung/Zum-Tode-von-Peter-Naur-Schlimmer-als-denkende-Maschinen-sind-Menschen-die-nicht-nachdenken-3059545.html [Stand: 31.01.2021].

Clark, A. C. (1973). Profiles of the future: An inquiry into the limits of the possible, S. 36

Deutscher Bundestag. (2011). Bericht der Enquete-Kommission „Internet und digitale Gesellschaft“ (Drucksache 17/7286).

Deutscher Bundestag. (2020). Bericht der Enquete-Kommission Künstliche Intelligenz – Gesellschaftliche Verantwortung und wirtschaftliche, soziale und ökologische Potenziale (Drucksache 19/23700).

Diethelm, I., Dörge, C., Mesaros, A.-M., & Dünnebier, M. (2011). Die Didaktische Rekonstruktion für den Informatikunterricht. In M. Thomas (Hrsg.), Informatik in Bildung und Beruf, INFOS 2011, 14. GI-Fachtagung Informatik und Schule (Bd. 189, S. 77–86). Gesellschaft für Informatik.

Diethelm, I., Koubek, J. & Witten, H., (2011). IniK — Informatik im Kontext. LOG IN: Vol. 31, No. 1. LOG IN Verlag GmbH. (S. 97-104).

Druga, S., Williams, R., Breazeal, C., & Resnick, M. (2017). „Hey, Google, is it OK if I eat you? “: Initial Explorations in Child-Agent Interaction. Proc. of the 2017 Conference on Interaction Design and Children, 595–600.

Forster, E. M. (2016). Die Maschine steht still (G. Runge, Übers.; 1. Auflage). Hoffmann und Campe.

GI – Gesellschaft für Informatik e.V. (Hrsg.)(2008). Grundsätze und Standards für die Informatik in der Sekundarstufe I. www.informatikstandards.de

GI – Gesellschaft für Informatik e.V. (Hrsg.)(2019). Kompetenzen für informatische Bildung im Primarbereich. www.informatikstandards.de

Humbert, L., & Puhlmann, H. (2004). Essential Ingredients of Literacy in Informatics. Informatics and Student Assessment. Concepts of Empirical Research and Standardisation of Measurement in the Area of Didactics of Informatics, 1, 65–76.

Humbert, L. (2020). #PflichtfachInformatik ab der 1. Klasse der Grundschule – Informatik gehört auf jedes Zeugnis. Wissensschule. https://www.wissensschule.de/pflichtfachinformatik-ab-der-1-klasse-der-grundschule-informatik-gehoert-auf-jedes-zeugnis/ [Stand 31.01.2021]

ICO & Turing. (2019). Information Commissioner’s Office and The Alan Turing Institute. Explaining decisions made with AI: Draft guidance for consultation – Part 1: The basics of explaining AI. Wilmslow, Cheshire, UK

Kattmann, U., Duit, R., Gropengießer, H., & Komorek, M. (1997). Das Modell der Didaktischen Rekonstruktion—Ein Rahmen für naturwissenschaftsdidaktische Forschung und Entwicklung. Zeitschrift für Didaktik der Naturwissenschaften, 3(3), 3–18.

Kling, M.-U. (2017). QualityLand: Roman. Ullstein Taschenbuch Verlag.

Long, D., & Magerko, B. (2020). What is AI Literacy? Competencies and Design Considerations. Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems, 1–16.

Naur, P. (1954). Elektronregnemaskinerne og hjernen. Perspektiv, 7(1), 42–46. http://www.naur.com/comp/c8-1.html [Stand: 01.06.2019].

Naur, P. (1968). Demokrati i datamatiseringens tidsalder. Kriterium, 3. årg.(5). Nyt Nordisk Forlag Arnold Busck.

Röhner, G., Brinda, T., Fricke, M., Gevers, M., Hug, A., Losch, D. & Puhlmann, H., (2020). Gemeinsamer Referenzrahmen Informatik (GeRRI) – Mindeststandards für die auf Informatik bezogene Bildung.

Seegerer, S., Michaeli, T., & Romeike, R. (2020). So lernen Maschinen! LOG IN – Informatische Bildung und Computer in der Schule, 40 (193/194).

Tinsley, J.D., Tagg, E.D. (eds.)(1984). Informatics in elementary education. Proceedings of the IFIP WG 3.1 Working Conference on Informatics in Elementary Education. Elsevier, Amsterdam.

Touretzky, D., Gardner-McCune, C., Martin, F., & Seehorn, D. (2019). Envisioning AI for K-12: What Should Every Child Know about AI? Proc. AAAI Conference on Artificial Intelligence, 33, 9795–9799.

Turing, A. M. (1950). I.—COMPUTING MACHINERY AND INTELLIGENCE. Mind, LIX(236), 433–460.

Webb, M.E., Fluck, A., Magenheim, J. et al. Machine learning for human learners: opportunities, issues, tensions and threats. Education Tech Research Dev (2020). https://doi.org/10.1007/s11423-020-09858-2

Wissenschaftsrat. (2020). Perspektiven der Informatik in Deutschland (Drs. 8675-20)

Zweig, K. A. (2019). Ein Algorithmus hat kein Taktgefühl: Wo Künstliche Intelligenz sich irrt, warum uns das betrifft und was wir dagegen tun können. Wilhelm Heyne Verlag

Zitationsvorschlag

Diethelm, I. 2021: Künstliche Intelligenz und Informatik. Im Rahmen des Projektes Digitales Deutschland. Online verfügbar: https://digid.jff.de/expertise-kuenstliche-intelligenz-und-informatik-prof-dr-ira-diethelm/.